Le machine learning représente aujourd’hui l’une des révolutions technologiques les plus marquantes de notre époque. Cette branche de l’intelligence artificielle transforme notre quotidien, des recommandations Netflix aux voitures autonomes, en passant par la détection de fraudes bancaires.

Cette technologie qui permet aux machines d’apprendre et de s’améliorer automatiquement à partir de données, sans programmation explicite, ouvre des possibilités infinies. Que vous soyez professionnel en reconversion, entrepreneur curieux ou simplement passionné de technologie, comprendre les principes du machine learning devient essentiel pour naviguer dans le monde numérique d’aujourd’hui.

- Qu'est-ce que le machine learning exactement ?

- Les trois piliers fondamentaux du machine learning

- Les algorithmes de machine learning incontournables en 2026

- Applications du machine learning dans tous les secteurs

- Les tendances machine learning émergentes en 2026

- Défis et considérations éthiques du machine learning

- Outils et plateformes pour débuter le machine learning

- L'avenir du machine learning

- Impact économique et transformation des métiers

- La réalité du Machine Learning

- Machine learning : questions fréquentes

Qu’est-ce que le machine learning exactement ?

Le machine learning, ou apprentissage automatique en français, constitue une méthode d’analyse de données qui automatise la construction de modèles analytiques. Contrairement à la programmation traditionnelle où nous écrivons des règles explicites, le machine learning permet aux systèmes d’identifier automatiquement des modèles dans les données et de prendre des décisions avec une intervention humaine minimale.

Cette approche révolutionnaire repose sur l’idée qu’un système peut apprendre à partir d’exemples, identifier des modèles dans les données et prendre des décisions éclairées lorsqu’il rencontre de nouvelles informations. Le processus ressemble étonnamment à l’apprentissage humain : nous observons, analysons et tirons des conclusions pour mieux appréhender les situations futures.

L’évolution du machine learning s’accélère considérablement en 2026. Les outils comme ChatGPT, Perplexity et Midjourney sont désormais utilisés quotidiennement au travail, témoignant de l’intégration massive de cette technologie dans nos activités professionnelles. Cette démocratisation s’accompagne d’une sophistication croissante des algorithmes et d’une accessibilité renforcée pour les non-experts.

Les trois piliers fondamentaux du machine learning

L’apprentissage supervisé : apprendre avec un guide

L’apprentissage supervisé fonctionne comme un élève qui apprend avec un professeur. Toutes les données sont étiquetées et les algorithmes apprennent à prédire la sortie à partir des données d’entrée. Cette méthode utilise des exemples d’entrée-sortie pour entraîner le modèle à faire des prédictions précises sur de nouvelles données.

La régression sert à prédire des valeurs continues comme les prix immobiliers, les cours boursiers ou la température, tandis que la classification prédit des catégories discrètes. Par exemple, un algorithme de régression peut estimer le prix d’une maison en fonction de sa superficie, de son emplacement et de son âge. Un modèle de classification déterminera si un email est un spam ou non.

Les applications de l’apprentissage supervisé sont omniprésentes dans notre quotidien. Netflix utilise ces algorithmes pour recommander des films en analysant vos habitudes de visionnage précédentes. Les banques emploient des modèles supervisés pour évaluer le risque de crédit d’un emprunteur en se basant sur l’historique de remboursement d’autres clients ayant des profils similaires.

L’apprentissage non-supervisé : découvrir l’invisible

L’apprentissage non-supervisé ressemble davantage à un explorateur qui découvre des territoires inconnus sans carte. Contrairement à l’apprentissage supervisé, les algorithmes non-supervisés découvrent des modèles et des relations cachées dans les données sans connaissance préalable de leur signification.

Cette approche excelle dans la découverte de structures cachées. Un algorithme de clustering peut segmenter automatiquement la clientèle d’une entreprise en groupes distincts selon leurs comportements d’achat, révélant des segments de marché jusqu’alors invisibles. Les techniques de réduction de dimensionnalité permettent de visualiser des données complexes en identifiant les caractéristiques les plus importantes.

Amazon utilise intensivement l’apprentissage non-supervisé pour identifier des produits fréquemment achetés ensemble, alimentant ainsi ses suggestions « Les clients qui ont acheté cet article ont également acheté ». Cette approche génère des milliards de dollars de revenus supplémentaires en révélant des associations de produits non évidentes.

L’apprentissage par renforcement : apprendre par l’expérience

L’apprentissage par renforcement s’inspire du conditionnement behavioriste : un agent apprend en interagissant avec son environnement et en recevant des récompenses ou des pénalités selon ses actions. En 2026, l’apprentissage par renforcement s’attaque à des défis de plus en plus sophistiqués, de l’optimisation des opérations d’entrepôt à la gestion des réseaux de distribution d’énergie.

Cette méthode brille particulièrement dans les situations complexes où les règles optimales ne sont pas évidentes. DeepMind a révolutionné ce domaine avec AlphaGo, qui a battu les meilleurs joueurs de Go au monde en apprenant uniquement en jouant contre lui-même. Plus récemment, des algorithmes similaires optimisent la consommation énergétique des centres de données Google, réduisant les coûts de refroidissement de 40%.

Les organisations adoptant l’apprentissage par renforcement peuvent construire des systèmes automatisés qui affinent leurs stratégies au fil du temps, améliorant la productivité et réduisant les coûts. Cette capacité d’amélioration continue différencie fondamentalement cette approche des méthodes traditionnelles de programmation.

Les algorithmes de machine learning incontournables en 2026

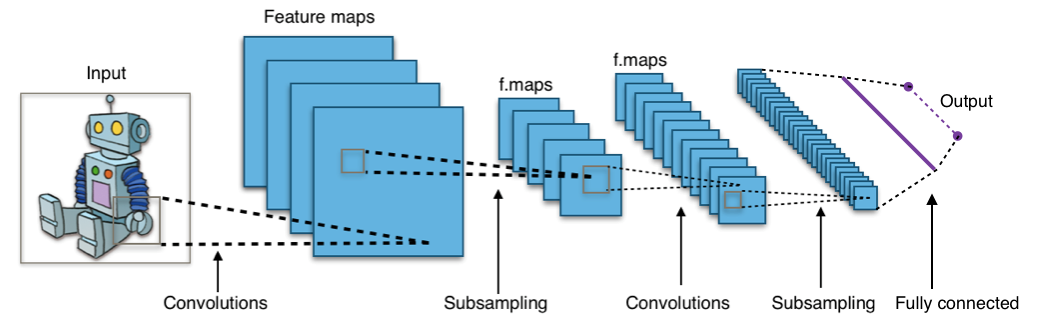

Les réseaux de neurones : l’inspiration biologique

Les réseaux de neurones artificiels s’inspirent du fonctionnement du cerveau humain pour traiter l’information. Ces modèles excellent dans la reconnaissance de formes complexes et la prise de décision nuancée. L’apprentissage profond (deep learning), utilisant des réseaux à multiples couches, révolutionne actuellement la reconnaissance d’images, le traitement du langage naturel et la génération de contenu.

Tesla utilise des réseaux de neurones convolutionnels pour analyser en temps réel les images captées par les caméras de ses véhicules. Ces algorithmes identifient instantanément les piétons, les véhicules, les panneaux de signalisation et les marquages routiers, permettant la conduite autonome. La complexité de cette tâche, impensable avec la programmation traditionnelle, devient accessible grâce à l’apprentissage profond.

Les machines à vecteurs de support : précision et robustesse

Les SVM (Support Vector Machines) excellent dans la classification et la régression, particulièrement efficaces avec des données de haute dimension. Leur capacité à créer des frontières de décision optimales les rend précieux pour des applications critiques comme le diagnostic médical ou la détection de fraudes.

Dans le domaine médical, les SVM analysent des images de scanners pour détecter des tumeurs cérébrales avec une précision souvent supérieure à celle des radiologues expérimentés. Cette performance s’explique par leur capacité à identifier des motifs subtils invisibles à l’œil humain, tout en évitant le sur-apprentissage grâce à leur approche mathématique rigoureuse.

Les forêts aléatoires : la sagesse collective

Les forêts aléatoires combinent de multiples arbres de décision pour créer un modèle plus robuste et précis. Cette approche d’ensemble réduit significativement le risque de sur-apprentissage tout en fournissant des prédictions fiables sur des données variées.

Airbnb utilise des forêts aléatoires pour estimer automatiquement le prix optimal des logements. L’algorithme analyse simultanément des centaines de variables : localisation, équipements, saisonnalité, demande locale, et prix de la concurrence. Cette approche permet aux propriétaires d’optimiser leurs revenus tout en restant compétitifs sur le marché.

Applications du machine learning dans tous les secteurs

Santé : vers une médecine personnalisée

Le machine learning transforme radicalement le secteur de la santé en permettant des diagnostics plus précis, des traitements personnalisés et une prévention proactive. IBM Watson for Oncology analyse des milliers d’études médicales pour recommander des traitements personnalisés contre le cancer, prenant en compte l’historique médical spécifique de chaque patient.

Les algorithmes de traitement d’images médicales atteignent désormais des performances remarquables. Google DeepMind a développé un système capable de diagnostiquer plus de 50 maladies oculaires avec une précision équivalente à celle des meilleurs spécialistes mondiaux. Cette technologie démocratise l’accès à des diagnostics de qualité, particulièrement précieuse dans les régions manquant de spécialistes.

La découverte de médicaments bénéficie également de cette révolution. AlphaFold, développé par DeepMind, prédit la structure tridimensionnelle des protéines avec une précision révolutionnaire, accélérant potentiellement le développement de nouveaux traitements de plusieurs années.

Finance : sécurité et optimisation

Dans le domaine financier, le machine learning améliore la détection de fraudes, le trading algorithmique et l’évaluation de crédit. Les algorithmes ML détectent les fraudes en identifiant des modèles de transaction anormaux et en s’adaptant aux menaces évolutives.

PayPal traite quotidiennement des millions de transactions en temps réel, utilisant des algorithmes sophistiqués pour détecter les activités frauduleuses en quelques millisecondes. Ces systèmes analysent simultanément des centaines de signaux : géolocalisation, habitudes d’achat, heure de transaction, type d’appareil utilisé, créant un profil comportemental unique pour chaque utilisateur.

Le trading haute fréquence exploite le machine learning pour identifier des opportunités d’arbitrage en microsecondes. Ces algorithmes analysent des flux de données massifs provenant de multiples bourses mondiales, détectant des inefficacités de marché impossibles à percevoir par des traders humains.

Transport : l’autonomie en marche

L’industrie automobile connaît sa plus grande révolution depuis l’invention du moteur à combustion. Les véhicules autonomes résultent principalement de la technologie de reconnaissance faciale, de l’analyse de sentiment, des chatbots, des robots intelligents et des fonctionnalités de commande vocale.

Waymo, la filiale d’Alphabet dédiée aux véhicules autonomes, a parcouru plus de 20 millions de miles sur routes publiques. Leurs algorithmes fusionnent les données de multiples capteurs : caméras, lidars, radars, créant une compréhension tridimensionnelle de l’environnement en temps réel. Cette approche multimodale garantit une redondance de sécurité essentielle pour la conduite autonome.

L’optimisation logistique révolutionne également le transport de marchandises. UPS utilise ORION (On-Road Integrated Optimization and Navigation), un système qui calcule les itinéraires optimaux pour ses chauffeurs. Cet algorithme économise quotidiennement des millions de miles de conduite, réduisant simultanément les coûts et l’empreinte carbone.

Marketing : lz personnalisation à grande échelle

En 2026, les stratégies de machine learning visent à fournir une expérience utilisateur ciblée sur de multiples appareils connectés. Cette personnalisation cross-platform révolutionne l’engagement client et l’efficacité marketing.

Spotify analyse les habitudes d’écoute de ses 500 millions d’utilisateurs pour créer des playlists personnalisées comme « Discover Weekly ». L’algorithme combine l’analyse collaborative (utilisateurs aux goûts similaires), l’analyse de contenu (caractéristiques musicales) et l’analyse du langage naturel (avis et blogs musicaux) pour découvrir de nouveaux artistes correspondant parfaitement aux préférences individuelles.

Amazon personnalise l’expérience de chaque visiteur en temps réel, modifiant la page d’accueil, les recommandations de produits et même les prix selon le profil comportemental. Cette hyper-personnalisation génère une augmentation de 35% du taux de conversion comparé à une approche générique.

Les tendances machine learning émergentes en 2026

Les modèles de langage spécialisés (SLM)

Les SLM ouvrent des possibilités pour des applications comme l’edge computing et l’IoT. Exécuter des modèles sur des appareils plus petits, comme un smartphone ou un ordinateur portable, améliore les performances dans des scénarios décentralisés. Cette évolution démocratise l’accès à l’IA tout en renforçant la confidentialité des données.

Apple Intelligence illustre parfaitement cette tendance en intégrant des modèles de langage optimisés directement dans ses appareils. Cette approche garantit une réactivité instantanée tout en préservant la confidentialité des données utilisateur, qui ne quittent jamais l’appareil.

L’IA multimodale : vers une compréhension globale

L’avenir du machine learning réside dans la capacité à traiter simultanément différents types de données : texte, images, audio, vidéo. GPT-4V de OpenAI démontre cette capacité en analysant des images et en générant des descriptions textuelles détaillées, ouvrant de nouvelles possibilités d’interaction homme-machine.

Cette convergence multimodale transformera des secteurs entiers. En éducation, des assistants IA pourront analyser les expressions faciales d’un étudiant regardant une vidéo éducative, détecter sa confusion et adapter automatiquement le contenu pour améliorer sa compréhension.

L’intégration IoT et 5G

En 2026, la confluence de l’IoT, de la blockchain et de la 5G transforme radicalement les applications ML, créant un écosystème plus interconnecté et efficace. Cette convergence technologique permet des applications temps réel à large échelle précédemment impossibles.

Les villes intelligentes exploitent cette synergie pour optimiser la circulation en temps réel. Des capteurs IoT surveillent continuellement le trafic, les algorithmes ML prédisent les embouteillages et ajustent automatiquement les feux de circulation, réduisant les temps de trajet de 20% dans certaines métropoles.

Défis et considérations éthiques du machine learning

La qualité des données : fondement de la performance du machine learning

La qualité des données détermine directement l’efficacité des modèles de machine learning. Des données biaisées produisent inévitablement des résultats biaisés, perpétuant parfois des discriminations sociétales. Amazon a dû abandonner son système automatisé de recrutement après avoir découvert qu’il discriminait systématiquement les candidatures féminines, ayant été entraîné sur des données historiques reflétant les biais de recrutement passés.

La collecte, le nettoyage et la validation des données représentent souvent 80% du temps consacré à un projet de machine learning. Cette étape, bien que moins glamour que le développement d’algorithmes, détermine fondamentalement le succès du projet.

Transparence et explicabilité des algorithmes de machine learning

L’opacité de certains algorithmes de machine learning pose des défis éthiques et réglementaires croissants. Les réseaux de neurones profonds, malgré leur efficacité, fonctionnent souvent comme des « boîtes noires » dont les décisions restent difficiles à expliquer. Cette limitation devient problématique dans des domaines critiques comme la justice pénale ou le diagnostic médical.

Le développement d’IA explicable (XAI – Explainable AI) répond à cette préoccupation en créant des modèles capables de justifier leurs décisions. LIME (Local Interpretable Model-agnostic Explanations) et SHAP (SHapley Additive exPlanations) permettent de comprendre l’influence de chaque variable sur une prédiction spécifique.

Protection de la vie privée et sécurité

L’apprentissage fédéré émerge comme une solution prometteuse pour concilier performance et confidentialité. Cette approche permet d’entraîner des modèles sur des données distribuées sans centraliser les informations sensibles. Google utilise cette technique pour améliorer la saisie prédictive de Gboard en apprenant des habitudes de frappe de millions d’utilisateurs sans jamais accéder à leurs messages privés.

Les attaques adverses représentent un défi sécuritaire croissant. Des modifications imperceptibles d’images peuvent tromper des systèmes de reconnaissance, soulevant des questions de sécurité pour les applications critiques comme la conduite autonome ou la surveillance de sécurité.

Outils et plateformes pour débuter le machine learning

Environnements de développement accessibles

Python domine l’écosystème du machine learning grâce à sa simplicité et sa richesse librairielle. Scikit-learn offre une introduction accessible aux algorithmes classiques, tandis que TensorFlow et PyTorch permettent de développer des modèles d’apprentissage profond sophistiqués.

Google Colab démocratise l’accès aux ressources de calcul nécessaires, offrant gratuitement des GPU pour l’entraînement de modèles. Cette plateforme permet aux débutants d’expérimenter sans investissement matériel initial, accélérant l’apprentissage pratique.

Plateformes no-code et low-code

L’émergence de plateformes no-code comme AutoML de Google Cloud ou Azure Machine Learning Studio permet aux non-programmeurs de créer des modèles performants. Ces outils automatisent la sélection d’algorithmes, l’optimisation d’hyperparamètres et l’évaluation de modèles, démocratisant l’accès au machine learning.

DataRobot illustre cette tendance en permettant la création de modèles prédictifs par simple glisser-déposer de fichiers de données. La plateforme gère automatiquement le prétraitement, la sélection de caractéristiques et l’ensemble des étapes techniques complexes.

Ressources d’apprentissage et communautés Machine Learning

Kaggle combine compétitions de data science, datasets publics et environnement de développement intégré. Cette plateforme permet d’apprendre en résolvant des problèmes réels tout en bénéficiant de l’expertise de la communauté mondiale de data scientists.

Coursera et edX proposent des cours spécialisés développés par des universités prestigieuses comme Stanford ou MIT. Ces formations structurées couvrent tant les aspects théoriques que pratiques, adaptées aux différents niveaux d’expertise.

L’avenir du machine learning

Machine Learning : vers l’intelligence artificielle générale

La convergence vers l’AGI (Artificial General Intelligence) représente l’horizon ultime du machine learning. Contrairement aux systèmes actuels spécialisés dans des tâches spécifiques, l’AGI viserait une intelligence flexible comparable à celle des humains. Bien que cet objectif reste lointain, les progrès récents en apprentissage par transfert et en architectures multimodales suggèrent une progression vers plus de généralité.

Quantum machine learning

L’informatique quantique promet de révolutionner certains aspects du machine learning en exploitant les propriétés quantiques pour accélérer exponentiellement certains calculs. IBM, Google et Microsoft investissent massivement dans cette convergence, anticipant des percées dans l’optimisation et l’apprentissage de motifs complexes.

Durabilité et green AI

La consommation énergétique massive de l’entraînement de modèles complexes soulève des questions environnementales. L’émergence du « Green AI » vise à développer des algorithmes plus efficaces énergétiquement, optimisant le rapport performance/consommation. Cette préoccupation influence déjà les choix architecturaux et pourrait redéfinir les priorités de recherche.

Impact économique et transformation des métiers

Le machine learning redéfinit le marché du travail de manière nuancée. Contrairement aux craintes de chômage technologique massif, l’histoire suggère plutôt une transformation des compétences requises. Les métiers routiniers disparaissent progressivement, remplacés par des rôles nécessitant créativité, empathie et capacité d’adaptation.

Les data scientists, ingénieurs ML et spécialistes en IA figurent parmi les professions les plus demandées. Parallèlement, des métiers traditionnels évoluent : les radiologues collaborent avec des IA pour des diagnostics plus précis, les traders utilisent des algorithmes pour identifier des opportunités, les marketeurs exploitent la personnalisation automatisée.

L’économie de plateforme amplifie ces transformations. Amazon Web Services, Google Cloud Platform et Microsoft Azure démocratisent l’accès aux infrastructures ML, permettant aux startups de concurrencer les géants technologiques. Cette démocratisation accélère l’innovation et redistribue la valeur économique.

La réalité du Machine Learning

Le machine learning n’est plus une technologie futuriste, mais une réalité qui transforme déjà notre quotidien. En 2026, sa maturité croissante et sa démocratisation ouvrent des opportunités sans précédent pour les entreprises, les professionnels et les particuliers curieux d’explorer ces nouvelles frontières.

Comprendre les principes fondamentaux du machine learning devient essentiel pour naviguer dans ce monde en mutation constante. Que vous souhaitiez optimiser votre activité professionnelle, développer de nouveaux produits innovants ou simplement satisfaire votre curiosité intellectuelle, les concepts et applications présentés dans cet article constituent un socle solide pour approfondir vos connaissances.

L’avenir appartient à ceux qui sauront tirer parti de cette révolution technologique tout en gardant à l’esprit les considérations éthiques et sociétales qu’elle soulève. Le machine learning n’est pas qu’une question d’algorithmes et de données, c’est avant tout un outil au service de l’amélioration de la condition humaine.

Machine learning : questions fréquentes

Le machine learning est une méthode qui permet aux ordinateurs d’apprendre automatiquement à partir de données, sans être explicitement programmés pour chaque tâche. Comme un enfant qui apprend à reconnaître des objets en voyant de nombreux exemples, les algorithmes ML identifient des motifs dans les données pour faire des prédictions ou prendre des décisions.

L’intelligence artificielle (IA) est un domaine large qui vise à créer des machines capables d’imiter l’intelligence humaine. Le machine learning est une sous-catégorie de l’IA qui se concentre spécifiquement sur l’apprentissage à partir de données. Toutes les applications ML sont de l’IA, mais toutes les applications d’IA n’utilisent pas nécessairement le machine learning.

L’apprentissage du machine learning dépend de votre background et de vos objectifs. Avec des bases en mathématiques et programmation, 3-6 mois suffisent pour maîtriser les concepts fondamentaux. Pour devenir expert, comptez 1-2 ans de pratique régulière. Les plateformes no-code permettent de débuter immédiatement sans connaissances techniques préalables.

Les secteurs les plus actifs incluent la technologie (recommandations, recherche), la finance (détection de fraudes, trading), la santé (diagnostic, découverte de médicaments), le transport (véhicules autonomes), le marketing (personnalisation) et l’e-commerce (optimisation des prix, gestion des stocks).

Le machine learning transforme les emplois plutôt que de les remplacer massivement. Les tâches routinières et prévisibles sont automatisées, tandis que de nouveaux métiers émergent (data scientist, ingénieur ML). Les compétences humaines comme la créativité, l’empathie et la résolution de problèmes complexes restent irremplaçables.

Python avec les bibliothèques Scikit-learn, Pandas et Matplotlib constitue un excellent point de départ. Google Colab offre un environnement gratuit avec accès aux GPU. Kaggle propose datasets, compétitions et environnement de développement. Pour le no-code, testez Orange ou WEKA.

Les données biaisées produisent des modèles discriminatoires qui perpétuent ou amplifient les inégalités existantes. Par exemple, un algorithme de recrutement entraîné sur des données historiques favorisant les hommes continuera à discriminer les femmes. La diversité des données d’entraînement et l’audit régulier des résultats sont essentiels.

L’apprentissage profond utilise des réseaux de neurones artificiels avec de nombreuses couches pour traiter l’information de manière similaire au cerveau humain. Cette approche excelle dans la reconnaissance d’images, le traitement du langage naturel et la génération de contenu. GPT-4, les voitures autonomes et la reconnaissance faciale utilisent l’apprentissage profond.