Vous utilisez des modèles d’intelligence artificielle mais leurs réponses manquent de précision sur vos données internes ? Le RAG (Retrieval-Augmented Generation) constitue la solution technique qui permet aux modèles de langage d’accéder à vos informations spécifiques pour générer des réponses précises et contextualisées. Cette approche combine la puissance générative des LLM avec la fiabilité de sources documentaires vérifiées, ouvrant la voie à des applications d’IA vraiment adaptées aux besoins des entreprises. Dans cet article complet, vous découvrirez le fonctionnement du RAG qui est intégré nativement dans des solutions comme Open WebUI, ses composants techniques, et comment l’implémenter pour créer des assistants IA performants qui exploitent vos propres données.

- Qu'est-ce que le RAG et pourquoi cette technique change la donne

- Comment fonctionne le RAG : architecture et composants techniques

- Les embeddings : la clé de la recherche sémantique dans le RAG

- Les bases de données vectorielles : stocker et rechercher efficacement

- Optimiser la stratégie de chunking pour améliorer le RAG

- Techniques avancées pour améliorer la qualité du RAG

- Applications concrètes du RAG en entreprise

- Implémenter un système RAG : méthodologie et bonnes pratiques

- Coûts et ressources nécessaires pour déployer le RAG

- Défis et limites

- Conformité : considérations réglementaires en 2026

- Questions fréquentes

Qu’est-ce que le RAG et pourquoi cette technique change la donne

Le RAG, ou Retrieval-Augmented Generation (Génération Augmentée par Récupération en français), représente une approche architecturale qui enrichit les capacités des modèles de langage en leur donnant accès à des sources de données externes. Contrairement aux modèles d’IA traditionnels qui s’appuient uniquement sur leurs données d’entraînement, le RAG interroge d’abord une base de connaissances pour récupérer les informations pertinentes, puis utilise ces informations comme contexte pour générer une réponse précise et actualisée.

Pour comprendre l’intérêt du RAG, imaginez une bibliothèque magique. Lorsque vous posez une question à un modèle d’IA classique, c’est comme demander à quelqu’un de répondre uniquement avec ce qu’il a en mémoire. Cette personne peut avoir oublié certains détails, ou ses connaissances datent de sa dernière mise à jour. Avec le RAG, c’est comme si cette personne consultait d’abord les livres les plus pertinents de la bibliothèque avant de vous répondre. Elle combine ainsi sa capacité à formuler des réponses claires avec l’exactitude des informations contenues dans les livres.

Le problème fondamental des modèles de langage réside dans leurs limitations inhérentes. Ces modèles, même les plus avancés comme GPT-4 ou Claude, possèdent une date de coupure des connaissances. Tout événement, document ou information postérieure à cette date leur est inconnu. Par ailleurs, ils ne disposent d’aucun accès à vos données internes, qu’il s’agisse de documentation technique, de procédures d’entreprise, de bases de connaissances clients, ou de contrats confidentiels. Enfin, ces modèles peuvent produire des hallucinations, c’est-à-dire inventer des informations plausibles mais totalement fausses, particulièrement lorsqu’ils ne connaissent pas la réponse.

Le RAG résout ces trois problèmes simultanément. En connectant le modèle à des sources de données actualisées, vous éliminez la contrainte de la date de coupure. En lui donnant accès à vos documents internes, vous créez un assistant IA qui comprend le contexte spécifique de votre organisation. En ancrant les réponses dans des documents réels et vérifiables, vous réduisez drastiquement les hallucinations, le modèle s’appuyant sur des faits plutôt que sur des suppositions.

Selon les études de marché, le RAG connaît une adoption massive dans les entreprises. Plus de 60% des organisations développent actuellement des solutions basées sur le RAG pour améliorer la fiabilité de leurs applications d’IA. Le marché mondial du RAG devrait passer de 1,96 milliards de dollars en 2025 à 40,34 milliards de dollars en 2035, avec un taux de croissance annuel de 35,31%, témoignant de l’importance stratégique de cette technologie.

Comment fonctionne le RAG : architecture et composants techniques

Le RAG repose sur une architecture en plusieurs étapes qui transforme une requête utilisateur en réponse informée et précise. Comprendre ce processus permet de mieux appréhender les choix techniques à effectuer lors de l’implémentation.

La première phase, l’indexation, se déroule en amont, avant même que l’utilisateur ne pose une question. Vos documents sources (PDF, Word, pages web, bases de données) sont d’abord collectés et préparés. Ces documents sont ensuite découpés en morceaux plus petits appelés « chunks » ou segments. Cette étape de chunking est cruciale car elle détermine la granularité de l’information récupérable. Un chunk trop petit manque de contexte, tandis qu’un chunk trop grand dilue l’information pertinente. La taille typique varie entre 200 et 1000 tokens, avec un chevauchement (overlap) de 10 à 20% entre les chunks consécutifs pour préserver la continuité du contexte.

Chaque chunk est ensuite converti en embedding, une représentation vectorielle numérique qui capture le sens sémantique du texte. Un modèle d’embedding comme OpenAI text-embedding-3-large, Jina Embeddings, ou all-MiniLM-L6-v2 transforme le texte en un vecteur de plusieurs centaines ou milliers de dimensions. Ces vecteurs sont conçus de manière à ce que des textes sémantiquement similaires produisent des vecteurs proches dans l’espace vectoriel. Par exemple, les embeddings de « voiture » et « automobile » seront très proches, tandis que « voiture » et « banane » seront éloignés.

Ces embeddings sont stockés dans une base de données vectorielle spécialisée comme Pinecone, Weaviate, Qdrant, Chroma, ou Milvus. Ces bases de données sont optimisées pour effectuer des recherches de similarité rapides sur des millions de vecteurs, utilisant des algorithmes comme HNSW (Hierarchical Navigable Small World) ou IVF (Inverted File Index) pour réduire la complexité de recherche de O(n) à O(log n).

La seconde phase, la récupération, se déclenche lorsqu’un utilisateur pose une question. La requête utilisateur est d’abord transformée en embedding en utilisant le même modèle d’embedding que pour l’indexation. Cette cohérence garantit que les vecteurs sont comparables. La base de données vectorielle effectue ensuite une recherche de similarité, typiquement basée sur la similarité cosinus ou la distance euclidienne, pour identifier les chunks les plus pertinents. Le système calcule le score de similarité entre le vecteur de la requête et tous les vecteurs stockés, puis retourne les top K chunks (généralement entre 3 et 10) les plus similaires.

Des techniques de reranking peuvent être appliquées pour affiner les résultats. Un modèle de reranking comme Cross-Encoder réévalue les chunks récupérés en tenant compte de la requête spécifique, améliorant la pertinence des documents finalement sélectionnés. Des filtres basés sur des métadonnées (date, auteur, type de document, département) peuvent également être appliqués pour contextualiser la recherche.

La troisième phase, l’augmentation, consiste à enrichir le prompt initial avec les informations récupérées. Cette étape utilise des techniques de prompt engineering pour structurer le contexte. Un template de prompt typique ressemble à ceci :

Contexte : Voici des informations pertinentes pour répondre à la question.

Document 1 : [contenu du chunk 1]

Document 2 : [contenu du chunk 2]

Document 3 : [contenu du chunk 3]

Question de l'utilisateur : [requête originale]

Instructions : Réponds à la question en te basant uniquement sur les informations fournies dans le contexte ci-dessus. Si l'information n'est pas présente dans le contexte, indique que tu ne peux pas répondre avec certitude.Ce prompt augmenté, qui combine les documents récupérés et la question, est envoyé au modèle de langage. Cette technique, parfois appelée « prompt stuffing », encourage le modèle à privilégier les informations fournies plutôt que ses connaissances générales.

La quatrième et dernière phase, la génération, fait intervenir le modèle de langage (LLM) comme GPT-4, Claude, Mistral, ou Llama. Le modèle analyse le prompt augmenté, comprend le contexte fourni par les documents récupérés, et génère une réponse qui synthétise les informations pertinentes. Comme le modèle dispose maintenant d’informations factuelles vérifiées, sa réponse sera plus précise, plus spécifique à votre domaine, et moins sujette aux hallucinations.

Cette architecture modulaire présente l’avantage de permettre des améliorations incrémentales. Vous pouvez changer le modèle d’embedding sans toucher au reste du système, optimiser la stratégie de chunking pour améliorer la pertinence, ou basculer entre différents LLM selon vos besoins de performance ou de coût. Vous pouvez exécuter vos LLMs localement avec Ollama.

Les embeddings : la clé de la recherche sémantique dans le RAG

Les embeddings constituent le cœur technique du RAG, car ils permettent la recherche sémantique qui fait toute la différence par rapport à une simple recherche par mots-clés.

Un embedding est un vecteur de nombres réels qui représente le sens d’un texte dans un espace mathématique de haute dimension. Contrairement à une recherche traditionnelle qui cherche des correspondances exactes de mots, les embeddings capturent le sens sémantique. Par exemple, une recherche sur « comment résilier mon abonnement » trouvera des documents contenant « procédure d’annulation de contrat » même si les mots exacts ne correspondent pas, car les embeddings de ces deux phrases seront proches dans l’espace vectoriel.

Les modèles d’embedding sont des réseaux de neurones entraînés spécifiquement pour cette tâche de transformation texte-vers-vecteur. Les modèles historiques comme Word2Vec (développé par Google en 2013) ont ouvert la voie, mais les modèles modernes basés sur l’architecture Transformer offrent des performances bien supérieures. Les embeddings contextuels produits par des modèles comme BERT, Sentence Transformers, ou les modèles d’OpenAI tiennent compte du contexte complet de la phrase, pas seulement des mots individuels.

Le choix du modèle d’embedding impacte directement la qualité de votre système RAG. Plusieurs critères doivent guider ce choix. La dimensionnalité du vecteur influence à la fois la richesse sémantique et les coûts de stockage et de calcul. OpenAI text-embedding-3-large produit des vecteurs de 3072 dimensions capturant des nuances très fines, tandis que all-MiniLM-L6-v2 produit des vecteurs de 384 dimensions plus compacts et rapides. La taille du contexte supporté détermine la longueur maximale de texte traitable en une fois, variant de 512 tokens pour les modèles anciens à 8192 tokens ou plus pour les modèles récents.

Le vocabulaire et la tokenisation influencent la manière dont le modèle traite les mots hors-vocabulaire. Les modèles utilisant la tokenisation par sous-mots (BPE, WordPiece) gèrent mieux les termes rares ou spécialisés. Le support multilingue s’avère crucial si vos documents sont dans plusieurs langues. Les performances sur des benchmarks comme MTEB (Massive Text Embedding Benchmark) donnent une indication objective de la qualité relative des modèles.

Les modèles d’embedding populaires en 2025 incluent OpenAI text-embedding-3-large et text-embedding-3-small, qui offrent d’excellentes performances avec une API facile d’utilisation mais des coûts récurrents. Jina Embeddings v3 propose des modèles open source performants avec support multilingue. all-MiniLM-L6-v2 reste un choix populaire pour les projets nécessitant légèreté et vitesse. Cohere Embed v3 se distingue par son support de plus de 100 langues. BGE (BAAI General Embedding) de Pékin offre d’excellentes performances en open source.

Une fois les embeddings générés, ils sont comparés à l’aide de métriques de similarité. La similarité cosinus mesure l’angle entre deux vecteurs et varie de -1 à 1, où 1 indique une similarité parfaite. Cette métrique est la plus utilisée dans les systèmes RAG car elle normalise automatiquement la magnitude des vecteurs, se concentrant sur l’orientation dans l’espace. La distance euclidienne (L2) calcule la distance en ligne droite entre deux points dans l’espace vectoriel. Le produit scalaire (dot product) combine magnitude et direction, utile lorsque la taille des vecteurs porte une signification.

Pour optimiser les performances, des techniques avancées peuvent être appliquées. La quantification compresse les vecteurs en réduisant leur précision (par exemple de float32 à int8), diminuant l’empreinte mémoire de 75% ou plus avec une perte de précision minime. Les indexes approximatifs (ANN – Approximate Nearest Neighbor) comme HNSW ou IVF sacrifient un peu de précision pour des gains massifs en vitesse, essentiels pour des bases de données de millions de vecteurs. Le fine-tuning des modèles d’embedding sur vos données spécifiques peut améliorer significativement la performance pour votre domaine particulier.

Les bases de données vectorielles : stocker et rechercher efficacement

Les bases de données vectorielles sont des systèmes spécialisés conçus pour stocker, indexer et rechercher des vecteurs de haute dimension avec une efficacité maximale.

Une base de données vectorielle diffère fondamentalement d’une base de données traditionnelle. Alors qu’une base SQL ou NoSQL organise les données en lignes, colonnes, ou documents avec des clés précises, une base de données vectorielle organise les données dans un espace géométrique multidimensionnel. La requête principale n’est pas « trouve l’enregistrement où ID = 123 » mais plutôt « trouve les 10 vecteurs les plus proches de ce vecteur requête ».

L’architecture de ces bases utilise des structures d’indexation sophistiquées. L’index HNSW (Hierarchical Navigable Small World) crée un graphe de navigation hiérarchique où chaque nœud (vecteur) est connecté à ses voisins les plus proches à différents niveaux de granularité. Cette structure permet une recherche en temps logarithmique plutôt que linéaire. L’index IVF (Inverted File) divise l’espace vectoriel en clusters (voronoi cells), puis recherche d’abord le cluster le plus pertinent avant de chercher dans ce cluster, réduisant considérablement l’espace de recherche.

Les principales solutions de bases de données vectorielles disponibles en 2026 offrent chacune des avantages spécifiques selon votre cas d’usage.

Pinecone représente une solution cloud native entièrement gérée, optimisée pour la simplicité et la scalabilité. L’API REST intuitive permet de démarrer en quelques minutes. Pinecone gère automatiquement l’infrastructure, la réplication, et la mise à l’échelle. Cette solution convient particulièrement aux équipes souhaitant se concentrer sur l’application plutôt que sur l’administration de base de données. Les coûts sont basés sur l’usage avec un tier gratuit limité.

Weaviate se distingue par ses capacités AI natives intégrées. Au-delà du simple stockage vectoriel, Weaviate peut générer automatiquement les embeddings, classifier les données, et répondre à des questions complexes grâce à ses modules AI intégrés. L’architecture modulaire et l’API GraphQL offrent une grande flexibilité. Weaviate supporte le multimodal (texte, images) nativement. Cette solution open source peut être auto-hébergée ou utilisée via le cloud Weaviate.

Qdrant combine performance et open source. Écrit en Rust, Qdrant offre d’excellentes performances avec une faible empreinte mémoire. Le support de filtres complexes et de métadonnées riches permet des recherches très ciblées. L’API est intuitive et la documentation complète. Qdrant peut être déployé sur votre infrastructure ou utilisé via leur cloud géré.

Chroma vise la simplicité maximale pour le prototypage rapide et les petites applications. Son API Python extrêmement simple permet de créer une base vectorielle en quelques lignes de code. L’intégration native avec LangChain et LlamaIndex facilite le développement de pipelines RAG complets. Chroma excelle pour les POC et les applications à échelle modérée, bien qu’il soit moins adapté aux très gros volumes.

Milvus offre une solution open source enterprise-grade avec des capacités de distribution et de clustering. Supportant des milliards de vecteurs avec latence faible, Milvus convient aux déploiements à très grande échelle. L’architecture distribuée permet la haute disponibilité et la tolérance aux pannes. La courbe d’apprentissage est plus raide que pour les solutions plus simples.

pgvector transforme PostgreSQL en base de données vectorielle en ajoutant un type de données vectoriel et des indexes spécialisés. Pour les organisations utilisant déjà PostgreSQL, pgvector permet d’ajouter des capacités vectorielles sans introduire une nouvelle base de données. Les données vectorielles et relationnelles coexistent dans le même système, simplifiant l’architecture. Les performances sont bonnes pour des volumes moyens, mais restent inférieures aux bases dédiées pour de très gros volumes.

Le choix de la base vectorielle dépend de plusieurs facteurs. Pour du prototypage rapide, Chroma ou pgvector (si vous utilisez déjà PostgreSQL) sont idéaux. Pour une mise en production avec gestion cloud simplifiée, Pinecone offre le meilleur compromis facilité-performance. Pour un contrôle total et un déploiement on-premise, Qdrant ou Milvus selon l’échelle. Pour des besoins multimodaux avancés ou des capacités AI intégrées, Weaviate se démarque.

Optimiser la stratégie de chunking pour améliorer le RAG

Le chunking, processus de découpage des documents en segments, influence directement la qualité des résultats du RAG. Une stratégie de chunking bien pensée peut faire la différence entre un système médiocre et un système excellent.

Le chunking fixe constitue l’approche la plus simple. Les documents sont découpés en chunks de taille fixe, par exemple 512 tokens, avec un overlap de 50 tokens entre chunks consécutifs. Cette méthode est rapide et prévisible, mais peut couper des phrases au milieu ou séparer des informations liées. Elle convient aux documents avec une structure uniforme comme des articles de blog ou de la documentation technique.

Le chunking par paragraphes ou sections respecte la structure naturelle du document. Les chunks correspondent aux divisions logiques du texte (titres, paragraphes, sections). Cette approche préserve mieux le contexte mais produit des chunks de tailles très variables. Elle fonctionne bien pour des documents structurés avec des titres clairs.

Le chunking sémantique utilise des modèles de langage pour identifier les frontières naturelles entre idées. L’algorithme détecte les changements de sujet et découpe à ces points de transition. Cette méthode produit des chunks cohérents sémantiquement, mais nécessite plus de traitement computationnel. Elle excelle pour des documents complexes comme des articles académiques ou des rapports détaillés.

Le chunking récursif essaie différentes stratégies dans un ordre de priorité. Par exemple : d’abord couper aux doubles sauts de ligne (paragraphes), puis aux simples sauts de ligne (phrases), puis à des délimiteurs de phrases, et enfin par caractères si nécessaire. Cette approche adaptative offre un bon compromis entre respect de la structure et contrôle de la taille.

Plusieurs paramètres affectent l’efficacité du chunking. La taille du chunk influence le compromis entre contexte et précision. Des chunks petits (200-300 tokens) offrent une grande précision en identifiant exactement l’information pertinente, mais peuvent manquer de contexte pour comprendre pleinement le sujet. Des chunks grands (800-1000 tokens) fournissent plus de contexte mais diluent l’information pertinente et consomment plus de tokens du LLM.

L’overlap entre chunks assure la continuité. Un overlap de 10-20% empêche qu’une information importante soit coupée entre deux chunks. Par exemple, avec des chunks de 500 tokens et un overlap de 100 tokens, chaque chunk commence 400 tokens après le précédent.

Les métadonnées enrichissent les chunks avec des informations contextuelles. Stocker le titre du document source, la date de création, l’auteur, le numéro de page, la section parente, ou des tags spécifiques permet des filtres précis lors de la récupération. Par exemple, pour une question sur « les procédures 2026 », vous pouvez filtrer les chunks par date de création supérieure à 2026.

Des techniques avancées de chunking peuvent encore améliorer les performances. Le chunking hiérarchique crée plusieurs niveaux de granularité. Au niveau document, vous stockez un résumé global. Au niveau section, vous stockez des résumés de sections. Au niveau chunk, vous stockez le contenu détaillé. Lors de la récupération, vous cherchez d’abord au niveau section, puis récupérez les chunks détaillés de la section pertinente.

L’expansion de contexte récupère non seulement le chunk le plus pertinent, mais aussi les chunks adjacents dans le document source. Si le chunk 42 est très pertinent, vous incluez aussi les chunks 41 et 43 pour fournir plus de contexte au LLM.

Le chunking par fenêtre glissante crée des chunks avec un overlap important (50% ou plus) pour garantir qu’aucune information ne soit perdue entre deux chunks. Cette approche augmente le nombre de chunks stockés mais améliore le recall (capacité à trouver toutes les informations pertinentes).

Techniques avancées pour améliorer la qualité du RAG

Au-delà de l’architecture de base, plusieurs techniques avancées permettent d’optimiser significativement la performance des systèmes RAG en 2026.

La recherche hybride combine recherche vectorielle (sémantique) et recherche lexicale (mots-clés). L’algorithme BM25, standard pour la recherche textuelle, excelle à trouver des correspondances exactes de termes rares ou techniques. En combinant les scores BM25 et les scores de similarité vectorielle, vous obtenez le meilleur des deux mondes : la précision lexicale et la compréhension sémantique. Des systèmes comme Weaviate et Qdrant supportent nativement cette recherche hybride.

Le reranking affine les résultats après la récupération initiale. Un modèle Cross-Encoder évalue chaque paire (requête, document) pour produire un score de pertinence plus précis que la simple similarité cosinus. Bien que plus coûteux computationnellement, le reranking améliore significativement la pertinence des documents finalement envoyés au LLM. Des modèles comme Cohere Rerank ou les Cross-Encoders de Sentence Transformers sont spécialement conçus pour cette tâche.

Le query expansion reformule la requête utilisateur pour améliorer la récupération. Le système peut générer plusieurs variantes de la requête (synonymes, reformulations), effectuer une recherche pour chaque variante, puis agréger les résultats. Par exemple, « comment résilier ? » pourrait s’étendre en « procédure de résiliation », « annulation de contrat », « arrêt du service ». Cette technique améliore le recall, particulièrement pour des requêtes courtes ou ambiguës.

Le SELF-RAG (Self-Reflective RAG) ajoute une couche d’auto-évaluation. Après avoir récupéré des documents, le système évalue d’abord leur pertinence avant de générer une réponse. Si les documents récupérés ne semblent pas pertinents, le système peut reformuler la requête, chercher ailleurs, ou indiquer qu’il ne peut pas répondre avec certitude. Cette approche réduit les hallucinations de 52% selon certaines études.

Le CRAG (Corrective RAG) détecte quand les informations récupérées sont obsolètes ou insuffisantes et déclenche automatiquement une recherche web pour compléter. Cette technique maintient les réponses à jour, particulièrement utile pour des informations changeant rapidement comme les cours boursiers, les actualités, ou les réglementations.

Le GraphRAG utilise des graphes de connaissances plutôt que de simples vecteurs. Les entités (personnes, lieux, concepts) et leurs relations sont modélisées explicitement dans un graphe. Cette structure capture mieux les relations complexes entre informations et permet des raisonnements multi-sauts (« qui est le PDG de l’entreprise fondée par la personne qui a inventé X ? »). Microsoft et d’autres acteurs développent activement des implémentations de GraphRAG.

Le Long RAG traite des documents très longs qui dépassent la fenêtre de contexte des LLM. Des techniques comme le résumé hiérarchique, le chunking multi-granularité, ou l’attention sélective permettent d’exploiter des documents de dizaines de milliers de tokens. Cette approche devient cruciale avec l’allongement des fenêtres de contexte des LLM modernes.

L’agentic RAG intègre le RAG dans des systèmes d’agents autonomes. L’agent peut planifier une stratégie de récupération multi-étapes, décider dynamiquement quelles sources interroger, combiner des informations de sources hétérogènes, et itérer si la première réponse est insatisfaisante. Cette approche représente la frontière actuelle de la recherche sur le RAG.

Le RAG multimodal étend les capacités au-delà du texte. Des systèmes avancés peuvent indexer et rechercher dans des images, des vidéos, ou des schémas techniques. Les modèles d’embedding multimodaux comme CLIP transforment images et texte dans le même espace vectoriel, permettant des requêtes cross-modales (« trouve des schémas montrant une architecture microservices »). Bien que prometteur, le RAG multimodal reste complexe à implémenter en 2026 à cause de l’immaturité de l’infrastructure.

Applications concrètes du RAG en entreprise

Le RAG trouve des applications dans une grande variété de secteurs et cas d’usage, transformant la manière dont les organisations exploitent leurs données.

Pour le support client et les chatbots, le RAG permet de créer des assistants virtuels vraiment utiles. Plutôt que de s’appuyer sur des arbres de décision rigides ou des réponses pré-écrites, un chatbot RAG peut accéder à toute la documentation produit, les FAQ, l’historique des tickets, et les procédures internes pour fournir des réponses précises et personnalisées. JetBlue a déployé « BlueBot », un chatbot basé sur le RAG qui donne accès à des données d’entreprise avec des permissions basées sur les rôles. L’équipe finance voit les données SAP et les documents réglementaires, tandis que l’équipe opérations accède aux informations de maintenance.

Dans la gestion des connaissances d’entreprise, le RAG transforme les vastes bases documentaires en ressources interrogeables. Les employés peuvent poser des questions en langage naturel et obtenir des réponses synthétisant plusieurs documents, avec références aux sources originales. Cela résout le problème classique de la documentation dispersée dans SharePoint, Confluence, Google Drive, et autres silos. Les gains de productivité sont substantiels, les employés passant moins de temps à chercher et plus de temps à créer de la valeur.

Pour les départements juridiques et de conformité, le RAG facilite la recherche dans des contrats, des réglementations, et de la jurisprudence. Un système RAG peut analyser des milliers de documents juridiques pour identifier les clauses pertinentes, vérifier la conformité réglementaire, ou trouver des précédents. La confidentialité absolue d’un RAG local garantit que les documents sensibles ne quittent jamais l’infrastructure de l’entreprise.

Dans le domaine médical et pharmaceutique, le RAG aide les professionnels de santé à rester à jour avec la littérature médicale en constante évolution. Un système RAG peut indexer des milliers d’articles scientifiques, des protocoles cliniques, et des dossiers patients (anonymisés) pour aider au diagnostic, suggérer des traitements basés sur les dernières recherches, ou identifier des interactions médicamenteuses. La capacité à citer précisément les sources est cruciale dans ce contexte réglementé.

Pour les ressources humaines, le RAG automatise de nombreuses tâches. Rechercher des candidats correspondant à un profil spécifique, répondre aux questions des employés sur les politiques RH, générer des descriptions de poste cohérentes avec le vocabulaire de l’entreprise, ou recommander des formations adaptées basées sur les compétences et objectifs de carrière. Un assistant RH basé sur RAG peut traiter les questions courantes 24/7, libérant les professionnels RH pour des tâches à plus haute valeur ajoutée.

Dans le domaine financier, Experian a développé « Latte », un chatbot RAG sur la plateforme Databricks pour gérer à la fois des besoins internes et clients. Le système améliore la gestion des prompts et la précision des modèles en s’appuyant sur les données financières internes et les réglementations sectorielles. Les analystes financiers utilisent le RAG pour rechercher dans des rapports annuels, des analyses de marché, et des données boursières pour prendre des décisions éclairées.

Pour la recherche et développement, le RAG accélère l’innovation en facilitant l’accès aux connaissances techniques. Les ingénieurs peuvent interroger des années de documentation technique, de rapports d’expérimentation, de brevets, et de notes de conception pour éviter de réinventer des solutions existantes ou s’inspirer de travaux antérieurs. Chevron Phillips Chemical utilise Databricks et le RAG pour l’automatisation du traitement documentaire dans leurs initiatives d’IA générative.

Dans le secteur commercial et marketing, le RAG aide à créer du contenu personnalisé à grande échelle. En accédant aux catalogues produits, aux fiches techniques, aux témoignages clients, et aux données de marché, un système RAG peut générer des descriptions produits cohérentes, des propositions commerciales adaptées à chaque prospect, ou des campagnes marketing ciblées. La marque voice reste cohérente car le système s’appuie sur vos propres documents plutôt que sur des générations génériques.

Pour la maintenance industrielle, le RAG transforme la documentation technique en assistant opérationnel. Les techniciens sur le terrain peuvent photographier une pièce défectueuse et demander la procédure de remplacement, ou décrire un symptôme et obtenir le diagnostic probable avec les étapes de résolution. Le système RAG accède aux manuels techniques, aux historiques de maintenance, et aux bases de connaissances pour fournir des réponses précises même dans des environnements sans expert humain disponible.

Implémenter un système RAG : méthodologie et bonnes pratiques

Le déploiement réussi d’un système RAG nécessite une approche méthodique qui prend en compte à la fois les aspects techniques et organisationnels.

La première étape consiste à identifier le cas d’usage et définir les objectifs. Posez-vous les questions suivantes : quelle tâche répétitive implique de rechercher dans des documents ? Quel volume de documentation devez-vous traiter ? Ces documents changent-ils fréquemment ? Quel niveau de précision est requis ? Des erreurs occasionnelles sont-elles acceptables ou chaque réponse doit-elle être parfaite ? Qui sont les utilisateurs finaux et quel est leur niveau technique ? Un cas d’usage bien défini facilite toutes les décisions subséquentes.

La deuxième étape implique l’audit et la préparation des données. Identifiez toutes les sources de données pertinentes : documentation technique, bases de connaissances, emails archivés, contrats, procédures, historiques de tickets. Évaluez la qualité de ces données : sont-elles à jour, complètes, bien structurées ? Des données de mauvaise qualité produiront un système RAG médiocre. Nettoyez et structurez les données si nécessaire. Ajoutez des métadonnées riches (date, auteur, département, type, tags) qui faciliteront le filtrage lors de la récupération. Déterminez la fréquence de mise à jour requise : certains documents changent quotidiennement, d’autres restent stables pendant des années.

La troisième étape concerne le choix de la stack technique. Pour les modèles d’embedding, évaluez plusieurs options sur vos données réelles. Les benchmarks publics ne reflètent pas toujours les performances sur vos données spécifiques. Pour la base vectorielle, commencez simple (Chroma pour prototypage) puis migrez vers une solution robuste (Pinecone, Qdrant, Weaviate) pour la production. Pour le LLM, testez plusieurs modèles : les modèles propriétaires (GPT-4, Claude) offrent généralement la meilleure qualité mais avec coûts et dépendance cloud, tandis que les modèles open source (Llama, Mistral) offrent contrôle et coûts prévisibles mais nécessitent plus d’infrastructure.

Le choix du mode de déploiement dépend de vos contraintes. Le déploiement cloud (SaaS) via des solutions comme Pinecone, OpenAI, ou Anthropic offre une mise en place rapide et une maintenance minimale, idéal pour les POC et les petites équipes. Cependant, les coûts augmentent avec l’usage et vous dépendez d’un fournisseur tiers pour vos données. Le déploiement hybride utilise le cloud pour certains composants (par exemple, le LLM) et l’on-premise pour d’autres (base vectorielle avec données sensibles). Cette approche équilibre flexibilité et contrôle. Le déploiement on-premise complet garantit contrôle total et confidentialité maximale, essentiel pour les données hautement sensibles, mais nécessite infrastructure GPU, compétences techniques, et maintenance continue.

La quatrième étape couvre l’implémentation et l’indexation. Développez le pipeline d’indexation qui charge les documents, les découpe en chunks, génère les embeddings, et les stocke dans la base vectorielle. Testez différentes stratégies de chunking sur un échantillon représentatif pour identifier l’approche optimale. Implémentez un système de mise à jour incrémentale : quand un document change, seuls les chunks affectés sont réindexés, évitant de retraiter toute la base. Pour les grandes bases documentaires, l’indexation initiale peut prendre plusieurs heures ou jours, planifiez en conséquence.

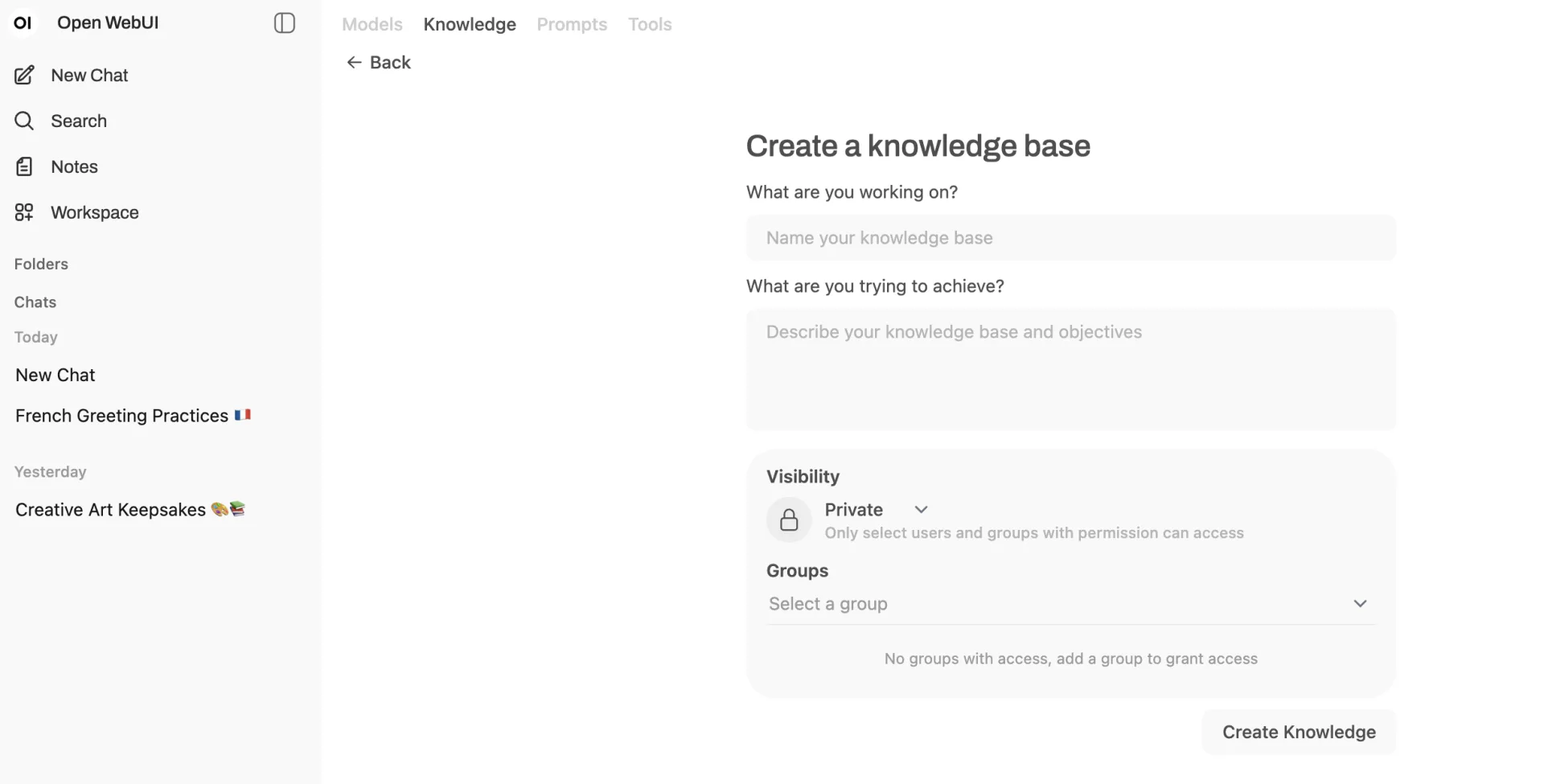

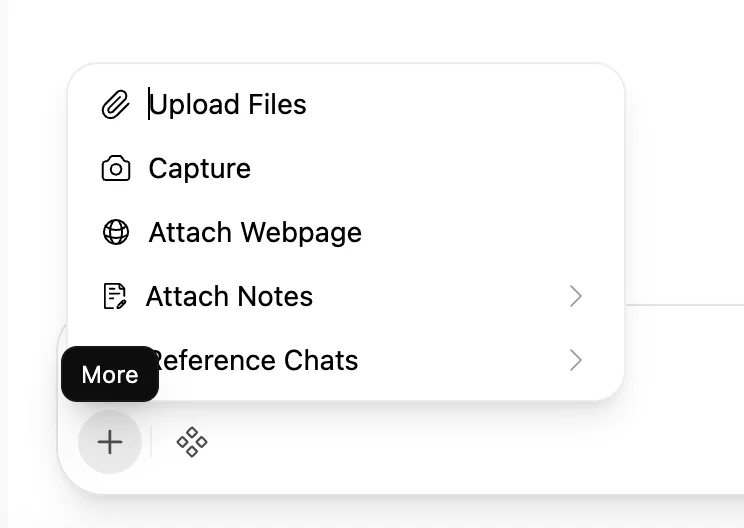

La cinquième étape développe le pipeline de requête et génération. Créez l’interface utilisateur adaptée à vos utilisateurs : chatbot web, intégration Slack/Teams, API pour d’autres applications. Implémentez la logique de récupération avec les paramètres optimaux (nombre de chunks, seuils de similarité, filtres métadonnées). Concevez les templates de prompts en testant différentes formulations pour maximiser la qualité des réponses. Ajoutez des mécanismes de citation des sources pour la traçabilité : chaque réponse doit indiquer quels documents ont été utilisés, permettant aux utilisateurs de vérifier l’information.

La sixième étape porte sur l’évaluation et l’optimisation. Créez un jeu de test avec des questions représentatives et leurs réponses attendues. Mesurez la pertinence de la récupération : les bons documents sont-ils récupérés ? Calculez des métriques comme Precision@K (proportion de documents récupérés qui sont pertinents) et Recall@K (proportion de documents pertinents qui sont récupérés). Évaluez la qualité des réponses générées : sont-elles factuelles, complètes, bien formulées ? Utilisez des frameworks comme RAGAS ou TruLens pour automatiser l’évaluation. Itérez sur les paramètres : taille de chunks, nombre de chunks récupérés, modèles, prompts.

La septième étape concerne le déploiement et la surveillance en production. Implémentez un monitoring robuste : suivez les métriques de performance (latence, taux d’erreur), les coûts (tokens consommés, requêtes API), et la satisfaction utilisateur. Collectez les feedbacks explicites (boutons pouce haut/bas) et implicites (reformulations de questions, abandons). Analysez les échecs : quelles questions ne reçoivent pas de bonnes réponses ? Manque-t-il des documents dans la base ? Le chunking est-il inadéquat ? Mettez en place un processus d’amélioration continue basé sur ces données.

La huitième et dernière étape est l’acculturation des utilisateurs. Formez les utilisateurs au prompt engineering : comment formuler des questions efficaces, quels détails inclure pour obtenir des réponses précises. Communiquez clairement les capacités et limitations du système : ce qu’il peut et ne peut pas faire, quand consulter un humain. Créez une documentation claire avec des exemples d’utilisation. Désignez des champions internes qui peuvent aider leurs collègues et remonter les problèmes.

Coûts et ressources nécessaires pour déployer le RAG

Comprendre les coûts réels d’un système RAG permet de budgétiser correctement et de faire des choix éclairés entre différentes options.

Les coûts de développement initial varient selon l’approche. Pour un POC simple utilisant des solutions SaaS (Pinecone, OpenAI), comptez 5 000 à 15 000 euros avec une équipe de 2-3 personnes (data scientist, développeur) pendant 2-4 semaines. Pour un déploiement production sur infrastructure cloud, le budget se situe entre 30 000 et 100 000 euros avec une équipe de 3-5 personnes sur 2-3 mois. Pour un déploiement on-premise complet avec fine-tuning et optimisations avancées, prévoyez 100 000 à 300 000 euros avec une équipe de 5-8 personnes sur 4-6 mois.

Les coûts d’infrastructure et d’opération récurrents se composent de plusieurs éléments. Pour les embeddings, compter environ 0,10 euro par million de tokens avec OpenAI, ou gratuit si vous utilisez des modèles open source hébergés localement. Pour le stockage vectoriel, Pinecone facture selon le nombre de vecteurs et la performance (environ 70 euros/mois pour 100 000 vecteurs), tandis que les solutions auto-hébergées nécessitent des serveurs (500-2000 euros/mois selon la taille). Pour les LLM, les coûts varient énormément : GPT-4 coûte environ 0,03 euro pour 1000 tokens en entrée, Claude 0,015 euro, tandis que les modèles open source comme Llama ou Mistral sont gratuits mais nécessitent des GPU (location de serveurs GPU : 500-3000 euros/mois selon la puissance).

Les ressources matérielles pour un déploiement local dépendent de l’échelle. Pour un petit système (moins de 100 000 documents, quelques utilisateurs), un serveur avec 32 Go RAM, 8 cœurs CPU, et 500 Go SSD suffit si vous utilisez des modèles d’embedding légers et un LLM externe. Pour un système moyen (100 000 à 1 million de documents, plusieurs dizaines d’utilisateurs), prévoyez 64-128 Go RAM, GPU NVIDIA avec 24 Go VRAM (comme une RTX 4090 ou A5000), et plusieurs To de SSD NVMe pour la base vectorielle. Pour un grand système (plusieurs millions de documents, centaines d’utilisateurs), une infrastructure distribuée devient nécessaire : cluster de serveurs avec GPUs multiples, stockage haute performance, load balancing. Le budget matériel peut atteindre 50 000 à 200 000 euros pour l’achat ou plusieurs milliers d’euros mensuels en location cloud.

Les compétences requises dans l’équipe incluent un data scientist ou ML engineer pour le choix et le fine-tuning des modèles d’embedding, l’optimisation des paramètres RAG, et l’évaluation des performances. Un développeur backend pour l’implémentation des pipelines d’indexation et de requête, l’intégration avec les systèmes existants, et le développement de l’API. Un développeur frontend ou fullstack pour créer l’interface utilisateur (chatbot, dashboard). Un administrateur système ou DevOps pour la gestion de l’infrastructure, le monitoring, et les déploiements, particulièrement crucial pour les déploiements on-premise. Un responsable données ou data steward pour la curation des documents sources, l’assurance qualité des données, et la gestion des mises à jour.

Les coûts cachés méritent attention. La préparation et le nettoyage des données prennent souvent plus de temps que prévu, particulièrement si vos documents sont mal structurés ou contiennent beaucoup de bruit. La maintenance continue est nécessaire : mise à jour des documents, ajustement des paramètres selon l’évolution des besoins, correction de bugs. La formation des utilisateurs et le support représentent un investissement non négligeable mais crucial pour l’adoption. Les itérations et améliorations post-lancement sont inévitables : aucun système n’est parfait dès le premier déploiement, planifiez du budget pour les améliorations continues.

Des options de financement et d’aides existent pour les entreprises françaises. Plusieurs dispositifs publics soutiennent l’adoption de l’IA, notamment les programmes France 2030, le crédit d’impôt recherche (CIR) pour les activités de R&D en IA, les aides régionales à la transformation numérique. Bpifrance propose des prêts et subventions pour les projets d’innovation incluant l’IA. Consulter le guide officiel de la DGE sur la RAG référencé sur entreprises.gouv.fr fournit des informations détaillées sur les aides disponibles.

Défis et limites

Malgré ses avantages, le RAG présente certaines limites et défis qu’il faut comprendre pour éviter les désillusions.

La qualité des données détermine directement la qualité du système. Un RAG ne peut pas compenser des documents mal écrits, obsolètes, contradictoires, ou incomplets. Si votre documentation contient des erreurs, le RAG les reproduira fidèlement. La préparation des données représente souvent 60 à 80% de l’effort total d’un projet RAG. Le garbage in, garbage out s’applique pleinement ici.

La fenêtre de contexte des LLM limite le nombre de chunks récupérables. Même avec les modèles modernes ayant des contextes de 128 000 ou 200 000 tokens, vous ne pouvez inclure qu’un nombre limité de documents dans le prompt. Si l’information pertinente est dispersée dans 50 documents différents, le RAG aura du mal à tout synthétiser. Des techniques comme le résumé hiérarchique ou le multi-hop reasoning peuvent atténuer ce problème mais augmentent la complexité.

Les hallucinations, bien que réduites, ne sont pas éliminées. Même avec des documents sources fiables, le LLM peut parfois inventer des détails, mélanger des informations de sources différentes de manière incorrecte, ou extrapoler au-delà de ce que les documents disent réellement. La vigilance reste nécessaire, particulièrement pour des applications critiques. L’ajout de mécanismes de vérification et de citation explicite des sources aide à détecter les hallucinations.

La latence peut être problématique pour certaines applications. Chaque requête nécessite de chercher dans la base vectorielle, de récupérer plusieurs documents, et de générer une réponse avec le LLM. L’ensemble peut prendre plusieurs secondes, voire plus pour des systèmes complexes. Pour des applications temps-réel ou conversationnelles, cette latence peut dégrader l’expérience utilisateur. L’optimisation de l’infrastructure, la mise en cache des résultats fréquents, et l’utilisation de modèles rapides peuvent améliorer les temps de réponse.

La complexité d’implémentation et de maintenance ne doit pas être sous-estimée. Un système RAG production comporte de nombreux composants (embedding model, base vectorielle, LLM, pipelines d’indexation et de requête, monitoring) qui doivent tous fonctionner harmonieusement. Les bugs peuvent être difficiles à diagnostiquer : est-ce un problème d’embedding, de récupération, ou de génération ? La maintenance continue est nécessaire car les documents changent, les modèles évoluent, et les besoins des utilisateurs se précisent.

Les coûts peuvent croître rapidement avec l’usage. Pour les solutions cloud, chaque requête consomme des tokens (embedding de la requête, contexte envoyé au LLM, réponse générée). Sur de gros volumes, les coûts API peuvent devenir substantiels. Le monitoring des coûts et l’optimisation continue sont essentiels pour maintenir la viabilité économique.

La confidentialité et la sécurité nécessitent une attention particulière. Si vous utilisez des APIs externes (OpenAI, Anthropic), vos données transitent par leurs serveurs. Même avec des garanties contractuelles, certaines organisations ne peuvent accepter ce risque. Un déploiement on-premise avec modèles open source devient alors nécessaire mais complexifie l’architecture. Le contrôle d’accès doit être granulaire : tous les utilisateurs ne doivent pas voir tous les documents. Implémenter un filtrage basé sur les permissions utilisateur dans le pipeline RAG ajoute de la complexité.

La dépendance à des technologies encore jeunes comporte des risques. Le paysage des outils RAG évolue rapidement. Des bases vectorielles populaires aujourd’hui peuvent être dépassées demain. Les modèles d’embedding s’améliorent constamment, potentiellement nécessitant une réindexation complète. Les LLM changent de version régulièrement avec des comportements parfois différents. Une architecture modulaire et une abstraction appropriée des dépendances externes atténuent ce risque.

Conformité : considérations réglementaires en 2026

L’adoption du RAG dans un contexte professionnel doit tenir compte du cadre réglementaire, particulièrement en Europe avec l’AI Act entré en vigueur.

Le règlement européen sur l’intelligence artificielle (AI Act) classe les systèmes d’IA selon leur niveau de risque. Un système RAG peut être considéré comme à haut risque s’il est utilisé dans des contextes sensibles listés à l’annexe III du règlement, comme la sélection de personnel, l’octroi de crédit, l’évaluation d’étudiants, ou l’assistance aux décisions judiciaires. Pour ces cas, des obligations strictes s’appliquent : documentation complète du système, traçabilité des décisions, surveillance humaine, robustesse et sécurité, transparence envers les utilisateurs. Avant de déployer un RAG dans ces contextes, une analyse détaillée de conformité est nécessaire.

Le RGPD (Règlement Général sur la Protection des Données) s’applique si le RAG traite des données personnelles. Les principes de minimisation des données, de limitation de la finalité, et de durée de conservation doivent être respectés. N’indexez que les données strictement nécessaires au cas d’usage. Informez les personnes concernées que leurs données sont utilisées dans un système d’IA. Obtenez le consentement approprié si requis. Permettez l’exercice des droits (accès, rectification, effacement) : comment un individu peut-il demander la suppression de ses données du système RAG ? Mettez en place des mesures techniques de sécurité : chiffrement des données au repos et en transit, contrôles d’accès stricts, journalisation des accès.

Les exigences sectorielles spécifiques s’ajoutent aux réglementations générales. Dans la santé, le RGPD s’applique strictement aux données de santé. Les systèmes d’aide au diagnostic sont considérés comme des dispositifs médicaux réglementés. Dans la finance, les règlements sectoriels (MIFID, Bâle III) imposent des exigences de traçabilité et d’explicabilité des décisions. Pour les données RH, la CNIL française a émis des lignes directrices strictes sur l’utilisation de l’IA dans le recrutement et la gestion du personnel.

Les bonnes pratiques de gouvernance des données incluent la documentation complète du système : quelles données sont utilisées, comment, par qui, dans quel but. La traçabilité des décisions : capacité à expliquer pourquoi une réponse particulière a été générée, quels documents ont été utilisés. Les audits réguliers : évaluation périodique de la qualité, de la sécurité, et de la conformité du système. La formation des utilisateurs aux aspects éthiques et légaux : sensibilisation aux biais potentiels, usage responsable. Les procédures de correction : comment signaler et corriger des erreurs, des biais, ou des usages inappropriés.

La propriété intellectuelle et les droits d’auteur doivent être considérés. Avez-vous le droit d’indexer tous les documents que vous utilisez ? Pour les documents internes, généralement oui. Pour les documents externes (articles de presse, publications scientifiques, livres), vérifiez les licences. Les réponses générées par le RAG peuvent-elles être considérées comme des œuvres dérivées ? La jurisprudence sur l’IA générative et le droit d’auteur évolue encore, une veille juridique est nécessaire.

Questions fréquentes

Oui, absolument. Un système RAG peut être déployé entièrement en local en utilisant des modèles d’embedding open source (comme all-MiniLM-L6-v2), une base vectorielle auto-hébergée (Qdrant, Chroma, Milvus), et un LLM local via Ollama (Llama, Mistral, Gemma). Cette configuration garantit qu’aucune donnée ne quitte votre infrastructure, idéal pour les environnements hautement sécurisés. Les performances dépendront de votre matériel, particulièrement de la présence de GPU pour le LLM.

Le fine-tuning modifie les poids internes du modèle en l’entraînant sur vos données pour qu’il apprenne un style, un vocabulaire, ou un comportement spécifique. Le RAG laisse le modèle inchangé mais lui fournit des informations externes au moment de la requête. Le fine-tuning convient pour changer la manière dont le modèle répond (ton, format), tandis que le RAG convient pour lui donner accès à des faits spécifiques. Ces approches sont complémentaires : vous pouvez fine-tuner un modèle sur votre domaine ET utiliser le RAG pour lui fournir des informations actualisées.

Cela dépend de plusieurs facteurs : la taille moyenne des documents, la puissance de calcul disponible, le modèle d’embedding utilisé. Avec un setup modeste (CPU standard, modèle d’embedding moyen), comptez environ 2 à 8 heures pour 100 000 documents de taille moyenne. Avec des GPUs et une parallélisation optimale, cela peut descendre à moins d’une heure. L’indexation est typiquement une opération batch qui se fait une fois initialement, puis de manière incrémentale pour les nouveaux documents.

Oui, si vous utilisez des modèles d’embedding multilingues comme mBERT, XLM-RoBERTa, ou les modèles multilingues de Cohere et Jina. Ces modèles projettent des textes de différentes langues dans le même espace vectoriel, permettant des recherches cross-lingues (une question en français peut récupérer des documents en anglais si pertinents). Pour le LLM, les modèles récents comme GPT-4, Claude, ou Mixtral gèrent naturellement plusieurs langues.

Implémentez un filtrage basé sur les permissions au niveau de la récupération. Chaque document ou chunk stocké doit avoir des métadonnées indiquant qui peut y accéder (rôles, départements, niveaux de clearance). Lors de la recherche vectorielle, appliquez un filtre qui n’autorise la récupération que des documents accessibles à l’utilisateur courant. La plupart des bases vectorielles modernes supportent le filtrage par métadonnées de manière efficace. Testez rigoureusement cette sécurité avant le déploiement en production.

Non, ils sont complémentaires. Les moteurs de recherche traditionnels (Elasticsearch, Solr) excellent à trouver des correspondances exactes, à gérer des requêtes structurées complexes, et offrent des performances prédictibles. Le RAG excelle à comprendre l’intention sémantique, synthétiser des informations de sources multiples, et fournir des réponses en langage naturel. L’approche hybride (recherche traditionnelle + RAG) combine souvent le meilleur des deux mondes : recherche rapide et précise + compréhension sémantique et génération de réponses.