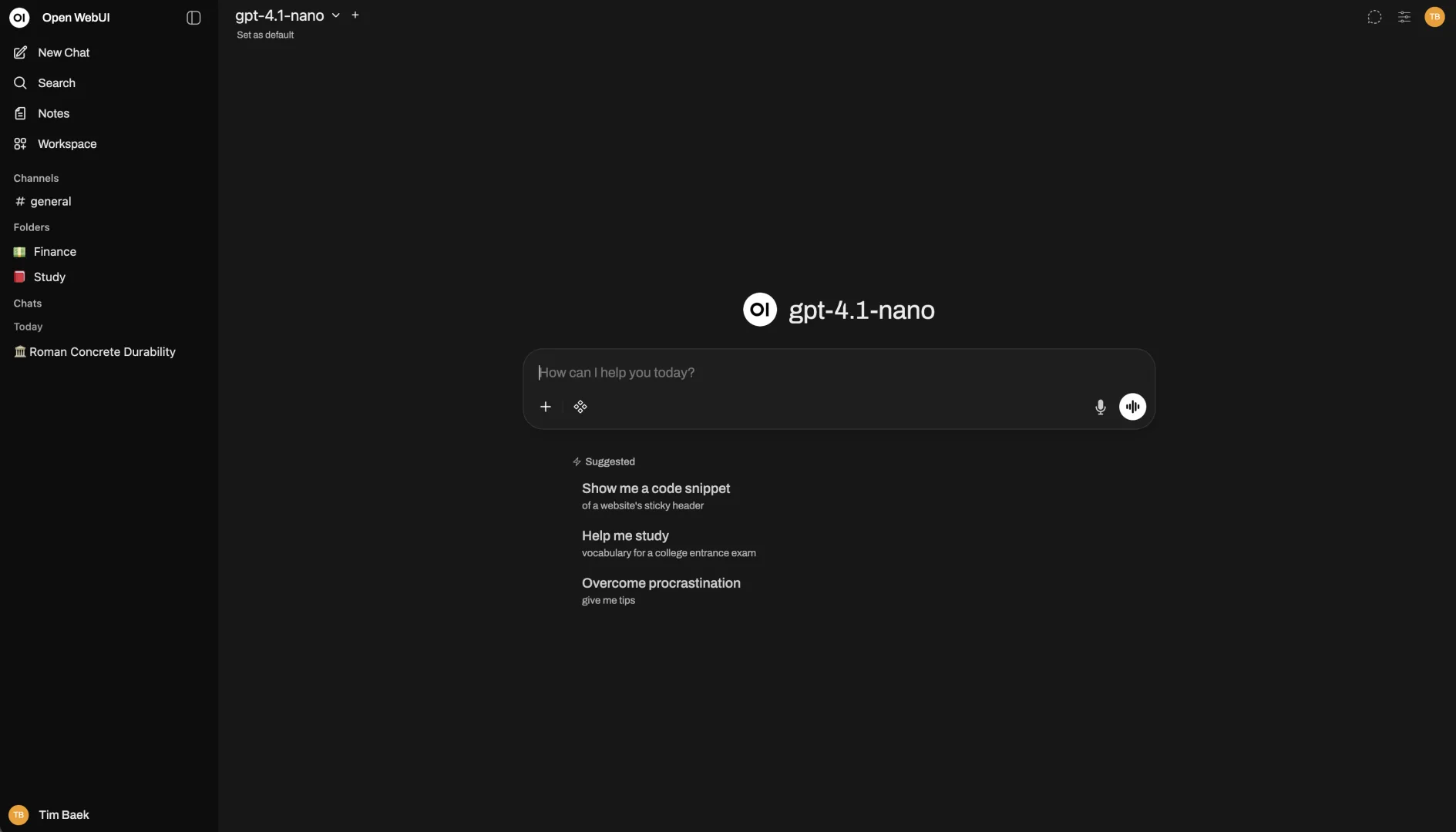

Open WebUI : l’interface web intuitive pour vos IA locales

Vous utilisez déjà Ollama pour exécuter des modèles d’intelligence artificielle en local, mais vous trouvez la ligne de commande peu pratique au quotidien ? Open WebUI représente la solution idéale pour transformer votre expérience d’utilisation des modèles d’IA locaux. Cette plateforme open source offre une interface web moderne et complète, similaire à ChatGPT, tout en

Open WebUI : l’interface web intuitive pour vos IA locales Lire la suite »