Vous utilisez déjà Ollama pour exécuter des modèles d’intelligence artificielle en local, mais vous trouvez la ligne de commande peu pratique au quotidien ? Open WebUI représente la solution idéale pour transformer votre expérience d’utilisation des modèles d’IA locaux. Cette plateforme open source offre une interface web moderne et complète, similaire à ChatGPT, tout en fonctionnant entièrement hors ligne sur votre propre infrastructure. Dans cet article, vous découvrirez comment installer et configurer Open WebUI pour exploiter pleinement vos modèles d’IA avec une interface professionnelle et des fonctionnalités avancées comme le RAG.

- Qu'est-ce qu'Open WebUI et pourquoi l'adopter

- Les fonctionnalités d'Open WebUI

- Installation d'Open WebUI avec Docker

- Installation d'Open WebUI avec Python

- Configurer la connexion entre Open WebUI et Ollama

- Utilisation au quotidien

- Exploiter le RAG avec Open WebUI

- Fonctionnalités avancées

- Gérer les utilisateurs et les permissions dans Open WebUI

- Sécuriser et optimiser votre instance Open WebUI

- Mettre à jour Open WebUI

- Open WebUI vs alternatives : quelle interface choisir

- Cas d'usage en entreprise

- Résoudre les problèmes courants avec Open WebUI

- Questions fréquentes

Qu’est-ce qu’Open WebUI et pourquoi l’adopter

Open WebUI est une plateforme web auto-hébergée, extensible et riche en fonctionnalités, conçue spécifiquement pour interagir avec des modèles de langage locaux. Initialement développée sous le nom « Ollama WebUI » pour fonctionner exclusivement avec Ollama, elle a évolué pour devenir une solution universelle compatible avec différents backends d’IA.

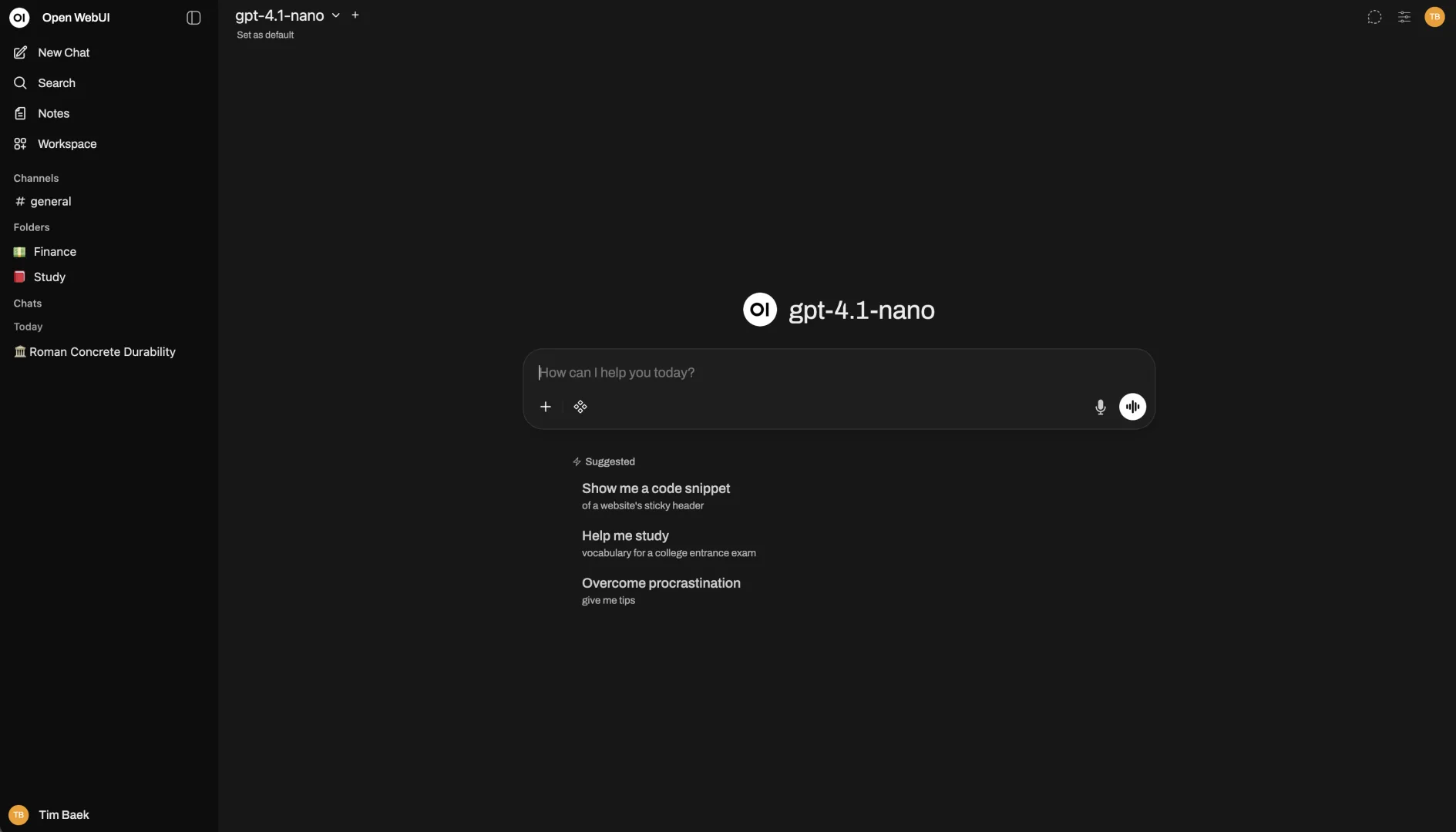

L’intérêt principal d’Open WebUI réside dans sa capacité à offrir une expérience utilisateur comparable aux interfaces commerciales comme ChatGPT ou Claude, tout en préservant les avantages du traitement local. L’interface présente un design soigné et moderne, avec une zone de conversation centrale, un historique de discussions accessible, et des options de configuration facilement accessibles. Cette approche rend l’intelligence artificielle locale accessible même aux utilisateurs non techniques qui ne souhaitent pas manipuler la ligne de commande.

Open WebUI supporte plusieurs backends simultanément. Au-delà d’Ollama, vous pouvez connecter l’interface à des API compatibles OpenAI, incluant des services comme LM Studio, GroqCloud, Mistral AI, OpenRouter, ou même des déploiements personnalisés. Cette flexibilité permet de basculer entre différentes sources de modèles selon vos besoins, en utilisant une seule interface unifiée.

La plateforme intègre nativement des fonctionnalités avancées qui enrichissent considérablement l’expérience utilisateur. Le support du RAG (Retrieval-Augmented Generation) permet d’ajouter vos propres documents comme source de connaissance pour les modèles. La gestion multi-utilisateurs avec des rôles et permissions granulaires rend Open WebUI adapté aux environnements professionnels ou éducatifs. L’historique complet des conversations, la possibilité de créer des modèles personnalisés, et l’intégration de fonctions Python personnalisées constituent autant d’atouts pour les usages avancés.

Les fonctionnalités d’Open WebUI

Open WebUI se distingue par un ensemble de fonctionnalités qui vont bien au-delà d’une simple interface de chat.

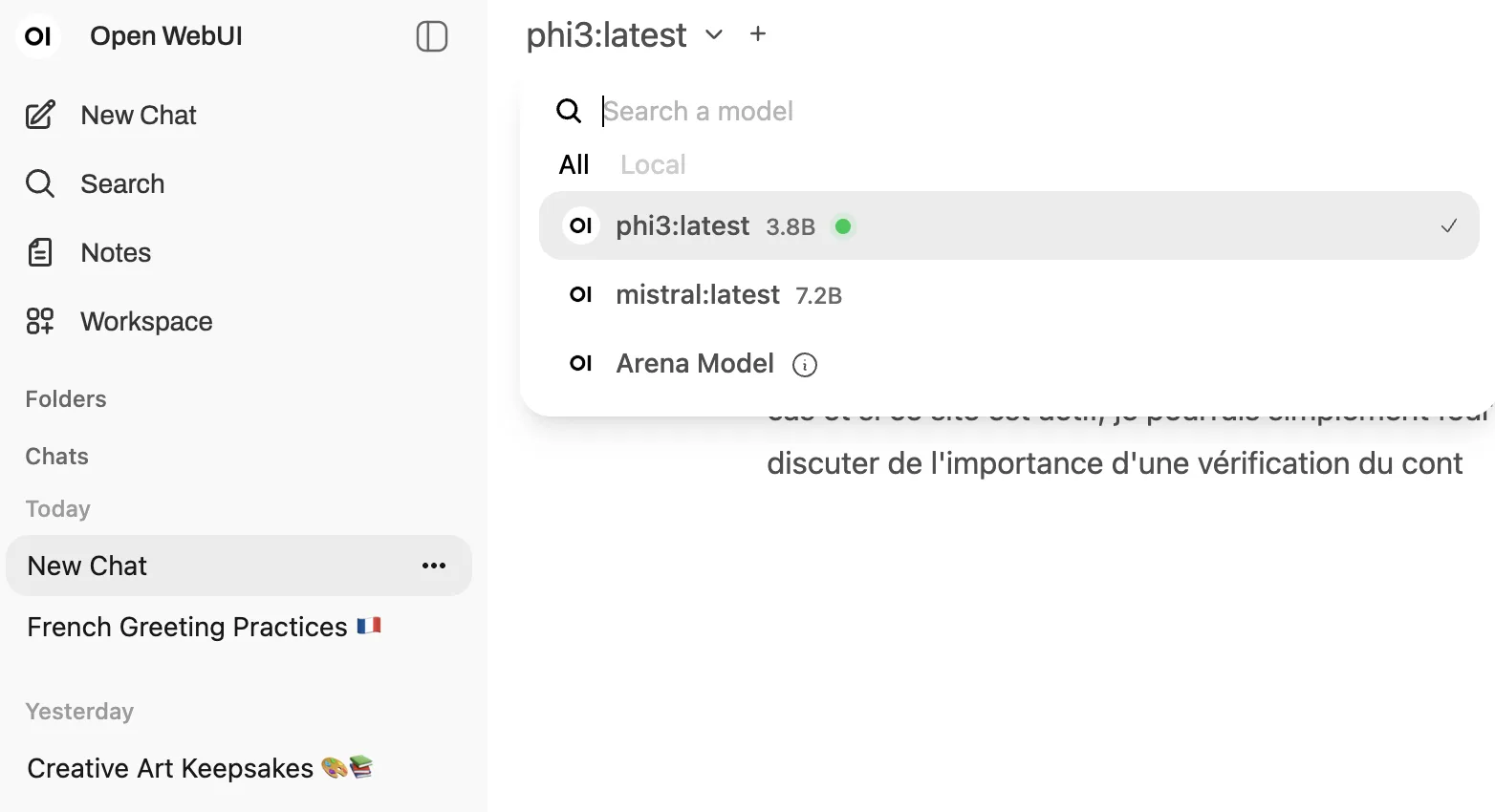

La gestion des modèles constitue l’un des points forts. Depuis l’interface, vous pouvez télécharger de nouveaux modèles Ollama simplement en tapant leur nom, sans passer par la ligne de commande. L’interface affiche la progression du téléchargement avec une barre visuelle. Vous pouvez basculer entre différents modèles en cours de conversation via un menu déroulant situé en haut à gauche, ce qui facilite la comparaison des réponses de différents modèles sur la même question. Open WebUI permet également d’utiliser plusieurs modèles simultanément dans une même conversation, exploitant leurs forces respectives pour obtenir des réponses optimales.

Le constructeur de modèles personnalisés (Model Builder) offre la possibilité de créer des variantes de modèles existants directement depuis l’interface web. Vous pouvez définir des personnages ou agents avec des instructions système spécifiques, ajuster les paramètres comme la température ou le contexte, et enregistrer ces configurations pour une réutilisation ultérieure. Cette fonctionnalité reproduit les capacités des Modelfiles d’Ollama, mais avec une interface graphique intuitive qui ne nécessite aucune connaissance technique.

L’historique et l’organisation des conversations permettent de retrouver facilement vos échanges passés. Chaque conversation peut être nommée, étiquetée, et organisée en dossiers. Vous pouvez archiver les discussions importantes, les partager avec d’autres utilisateurs, ou les exporter pour une utilisation externe. La fonction de recherche dans l’historique facilite la récupération d’informations spécifiques abordées lors de conversations précédentes.

Le support natif du Markdown et du LaTeX améliore la présentation des réponses. Les modèles peuvent formater leurs réponses avec des titres, des listes, des tableaux, du code avec coloration syntaxique, et des formules mathématiques qui s’affichent correctement. Cette capacité s’avère particulièrement utile pour les explications techniques, scientifiques ou pédagogiques.

Open WebUI intègre également des capacités multimodales pour les modèles compatibles. Vous pouvez envoyer des images aux modèles de vision comme Llama 3.2 Vision ou LLaVA et poser des questions sur leur contenu. L’interface supporte la synthèse vocale (TTS) et la reconnaissance vocale (STT), permettant d’interagir avec l’IA de manière vocale plutôt que textuelle. Ces fonctionnalités vocales peuvent être configurées avec différents backends, incluant des solutions locales comme SpeechT5.

La gestion multi-utilisateurs transforme Open WebUI en solution collaborative. Un administrateur peut créer des comptes utilisateurs, définir des rôles avec des permissions spécifiques, et contrôler l’accès à certains modèles ou fonctionnalités. Cette architecture rend la plateforme adaptée aux équipes, aux établissements d’enseignement, ou aux entreprises souhaitant déployer une solution d’IA centralisée.

Installation d’Open WebUI avec Docker

L’installation peut se faire de plusieurs manières, mais la méthode Docker reste la plus simple et la plus fiable pour la majorité des utilisateurs.

Docker permet de déployer Open WebUI dans un conteneur isolé avec toutes ses dépendances, évitant les conflits de versions et les problèmes de configuration. Avant de commencer, assurez-vous que Docker est installé sur votre système. Sur Windows, téléchargez Docker Desktop depuis le site officiel de Docker. Sur macOS, installez également Docker Desktop. Sur Linux, utilisez le gestionnaire de paquets de votre distribution, par exemple sudo apt install docker.io sur Ubuntu.

Pour installer Open WebUI avec Ollama déjà installé localement, utilisez la commande suivante dans votre terminal :

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:mainCette commande télécharge l’image Open WebUI, crée un conteneur nommé « open-webui », expose l’interface sur le port 3000, et configure la connexion avec Ollama qui tourne sur votre machine hôte. Le paramètre -v open-webui:/app/backend/data crée un volume Docker pour persister vos données (conversations, configurations, documents) même si vous supprimez et recréez le conteneur.

Si vous préférez une installation tout-en-un incluant à la fois Open WebUI et Ollama dans le même conteneur, utilisez cette commande pour les systèmes avec GPU :

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollamaPour les systèmes sans GPU, remplacez --gpus=all par -v ollama:/root/.ollama. Cette approche simplifie le déploiement en regroupant tous les composants nécessaires dans un seul conteneur.

Une fois le conteneur lancé, ouvrez votre navigateur et accédez à http://localhost:3000. Lors de votre première visite, Open WebUI vous invite à créer un compte administrateur. Renseignez un nom d’utilisateur, une adresse email et un mot de passe. Ce compte administrateur disposera de tous les privilèges pour gérer l’instance Open WebUI.

Pour les utilisateurs souhaitant utiliser la dernière version en développement avec les fonctionnalités les plus récentes (mais potentiellement instables), remplacez :main par :dev dans la commande Docker. Cette branche de développement contient les nouveautés avant leur intégration à la version stable.

Installation d’Open WebUI avec Python

Pour les utilisateurs qui préfèrent éviter Docker ou qui souhaitent une installation plus légère, Open WebUI peut être installé directement via Python.

Cette méthode nécessite Python 3.11 installé sur votre système. Python 3.12 semble fonctionner mais n’a pas été testé de manière exhaustive. Python 3.13 n’est pas encore entièrement compatible avec toutes les dépendances d’Open WebUI.

La méthode recommandée utilise uv, un gestionnaire d’environnement Python moderne qui simplifie la gestion des dépendances. Pour installer uv, suivez les instructions officielles adaptées à votre système d’exploitation. Sur macOS et Linux, exécutez curl -LsSf https://astral.sh/uv/install.sh | sh. Sur Windows, téléchargez l’installeur depuis le site d’uv.

Une fois uv installé, vous pouvez lancer Open WebUI avec une simple commande. Sur Linux ou macOS :

DATA_DIR="$HOME/.open-webui" uvx --python 3.11 open-webui@latest serveSur Windows (PowerShell) :

$env:DATA_DIR="$env:USERPROFILE\.open-webui"; uvx --python 3.11 open-webui@latest serveLa variable DATA_DIR spécifie où Open WebUI stockera vos données. Définir cette variable évite la perte de données lors des mises à jour.

Pour les utilisateurs préférant pip, installez Open WebUI avec :

pip install open-webuiPuis lancez l’application avec :

open-webui serveL’installation par défaut utilise une version allégée d’Open WebUI. Si vous avez besoin du support PostgreSQL ou d’autres dépendances optionnelles, installez avec :

pip install open-webui[all]Après le lancement, Open WebUI sera accessible à http://localhost:8080 (notez que le port diffère de l’installation Docker qui utilise 3000 par défaut).

Sur Windows, une installation via Miniconda3 offre une alternative intéressante. Téléchargez et installez Miniconda3, puis créez un environnement virtuel avec conda create -n openwebui python=3.11. Activez l’environnement avec conda activate openwebui, puis installez Open WebUI avec pip dans cet environnement.

Configurer la connexion entre Open WebUI et Ollama

La configuration de la connexion entre Open WebUI et Ollama varie selon votre méthode d’installation.

Si vous avez utilisé l’image Docker open-webui:ollama qui regroupe les deux composants, aucune configuration n’est nécessaire. La connexion est automatiquement établie en interne.

Si Ollama et Open WebUI tournent sur la même machine mais dans des environnements séparés (par exemple Ollama installé nativement et Open WebUI dans Docker), Open WebUI devrait automatiquement détecter Ollama à l’adresse http://host.docker.internal:11434. Cette détection fonctionne grâce au paramètre --add-host=host.docker.internal:host-gateway dans la commande Docker.

Pour vérifier ou modifier la configuration de connexion, connectez-vous à Open WebUI en tant qu’administrateur, cliquez sur votre nom en haut à droite, puis sélectionnez « Admin Panel ». Dans le panneau d’administration, naviguez vers « Settings » puis « Connections ». Vous verrez une section « Ollama API » avec l’URL de connexion. L’URL par défaut devrait être http://localhost:11434 pour une installation native, ou http://host.docker.internal:11434 pour Docker.

Cliquez sur l’icône de clé à molette à côté de l’URL pour tester la connexion. Si la connexion échoue, vérifiez que le service Ollama est bien démarré. Sur Linux, utilisez systemctl status ollama. Sur Windows et macOS, assurez-vous que l’application Ollama est lancée.

Si Ollama tourne sur une machine distante, modifiez l’URL pour pointer vers l’adresse IP ou le nom d’hôte de cette machine, par exemple http://192.168.1.100:11434. Assurez-vous que le pare-feu autorise les connexions sur le port 11434.

Pour les utilisateurs souhaitant connecter Open WebUI à plusieurs instances Ollama simultanément ou à d’autres backends compatibles OpenAI, la section « Connections » permet d’ajouter plusieurs sources. Cliquez sur le bouton « + » pour ajouter une nouvelle connexion, spécifiez l’URL de l’API et, si nécessaire, une clé API pour les services externes.

Utilisation au quotidien

Une fois Open WebUI configuré, l’utilisation quotidienne devient intuitive et agréable.

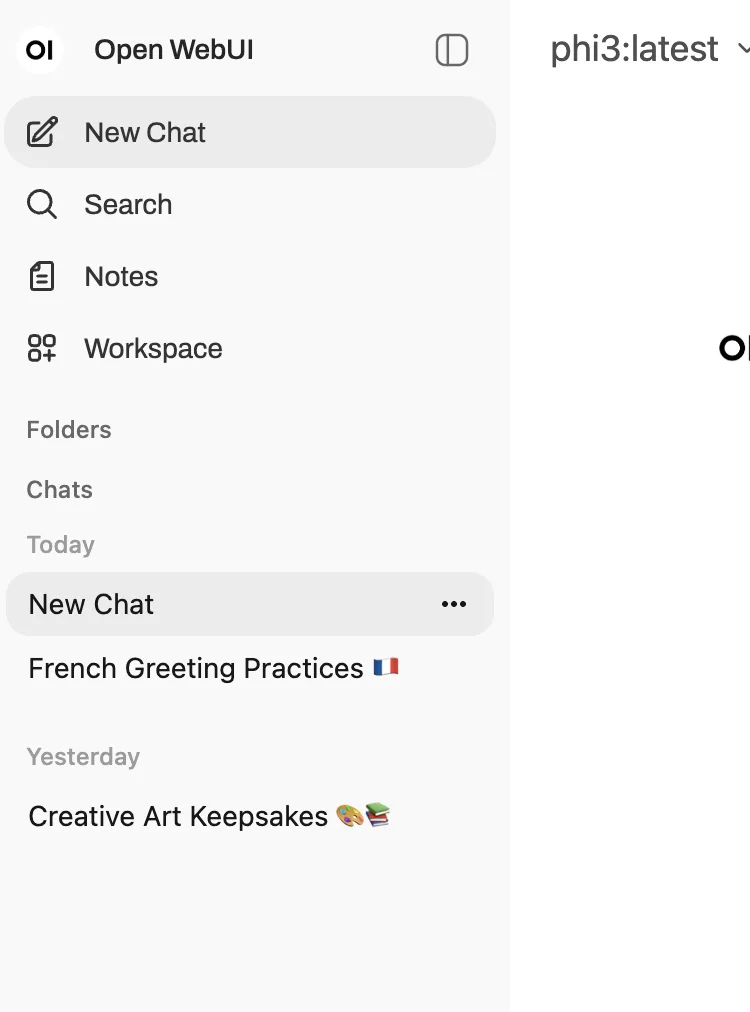

Pour démarrer une nouvelle conversation, cliquez sur le bouton « New Chat » (ou l’icône « + » selon la version). Un menu déroulant en haut à gauche vous permet de sélectionner le modèle à utiliser. Cette liste affiche tous les modèles disponibles dans votre instance Ollama. Si le modèle souhaité n’apparaît pas, vous pouvez le télécharger directement depuis Open WebUI en cliquant sur l’icône de téléchargement et en tapant son nom (par exemple « llama3.2 » ou « mistral »).

La zone de saisie principale se trouve en bas de l’écran. Tapez votre question ou requête, puis appuyez sur Entrée ou cliquez sur le bouton d’envoi. Le modèle génère sa réponse en temps réel, le texte apparaissant progressivement comme dans une conversation naturelle. Pour les modèles supportant le raisonnement en plusieurs étapes (comme DeepSeek-R1), Open WebUI affiche un indicateur « Thinking » pendant la phase de réflexion, puis présente le résultat final une fois le traitement terminé.

L’historique des conversations s’affiche dans une barre latérale gauche. Chaque conversation est automatiquement nommée selon son contenu, mais vous pouvez renommer, archiver, ou supprimer les discussions en cliquant sur les trois points à côté de chaque conversation. Pour retrouver une discussion ancienne, utilisez la barre de recherche en haut de la liste de l’historique.

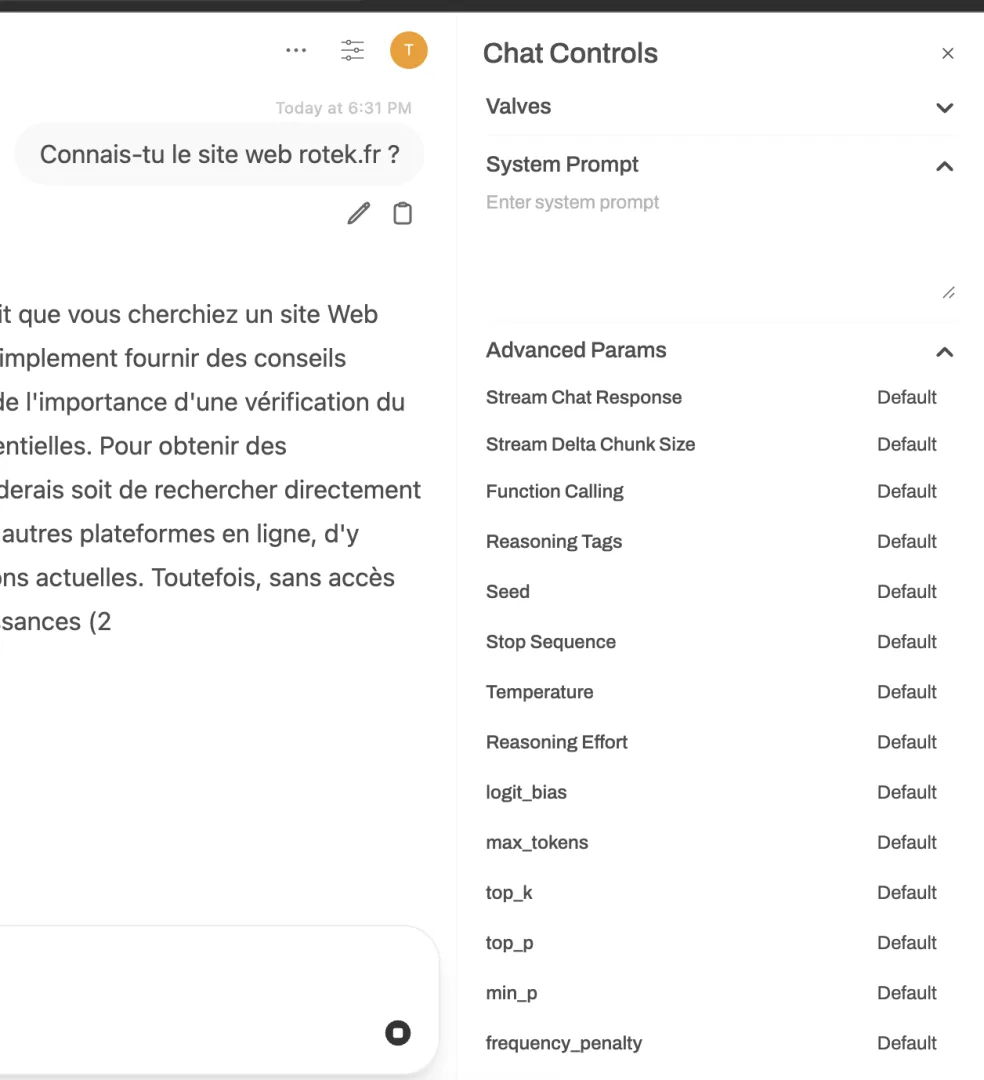

Open WebUI permet de personnaliser chaque conversation avec des paramètres spécifiques. Cliquez sur l’icône de réglages dans la zone de conversation pour accéder aux options avancées. Vous pouvez ajuster la température pour contrôler la créativité, modifier la taille du contexte (num_ctx) pour des conversations plus longues, ou activer/désactiver le streaming des réponses.

Pour comparer les réponses de différents modèles sur une même question, Open WebUI offre une fonctionnalité particulièrement utile. Dans le menu de sélection du modèle, cochez plusieurs modèles au lieu d’un seul. Lorsque vous envoyez une question, chaque modèle génère sa propre réponse dans des colonnes séparées, facilitant la comparaison et vous permettant de choisir la meilleure réponse.

La fonctionnalité de « régénération » permet de demander au modèle de produire une nouvelle réponse sans réécrire votre question. Cliquez sur l’icône de régénération à côté d’une réponse pour obtenir une variante. Vous pouvez également éditer vos messages précédents en cliquant dessus, ce qui recalcule toute la suite de la conversation à partir de votre modification.

Exploiter le RAG avec Open WebUI

Le RAG (Retrieval-Augmented Generation) constitue l’une des fonctionnalités les plus puissantes d’Open WebUI, permettant d’enrichir les modèles avec vos propres documents et sources de connaissance.

Le concept du RAG fonctionne comme une bibliothèque magique pour votre IA. Lorsque vous posez une question, le système recherche d’abord les informations pertinentes dans vos documents, puis les fournit au modèle comme contexte additionnel. Le modèle génère alors une réponse basée à la fois sur ses connaissances générales et sur le contenu spécifique de vos documents. Cette approche permet d’obtenir des réponses précises sur des sujets que le modèle ne connaît pas nativement, comme vos données internes, vos procédures d’entreprise, ou des événements récents.

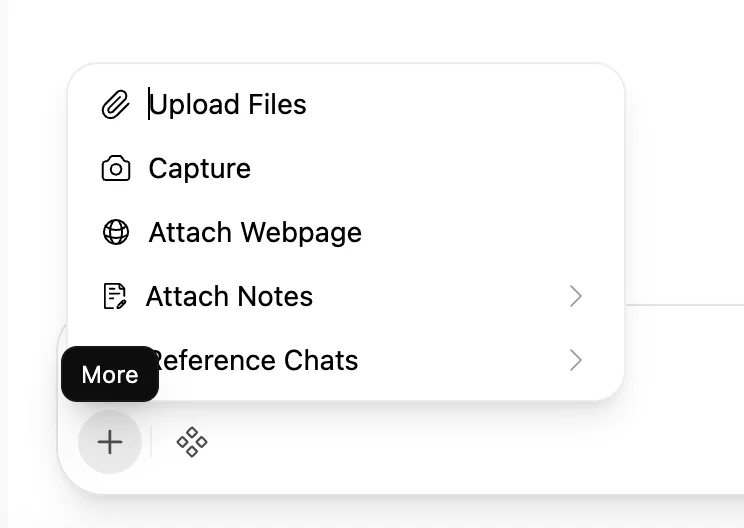

Pour utiliser le RAG de manière ponctuelle, le moyen le plus simple consiste à cliquer sur le bouton « + » à gauche de la zone de saisie de message. Vous pouvez alors sélectionner un ou plusieurs fichiers depuis votre ordinateur. Open WebUI supporte une grande variété de formats : PDF, documents Word (DOC, DOCX), feuilles de calcul Excel (XLS, XLSX), présentations PowerPoint (PPT, PPTX), fichiers texte (TXT, MD), et même des fichiers audio pour la transcription. Une fois le fichier chargé, une icône de document apparaît au-dessus de la zone de saisie, confirmant que ce fichier sera utilisé comme contexte pour votre prochaine question.

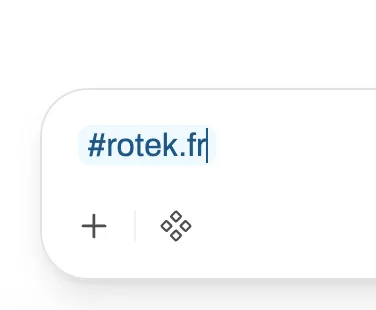

Vous pouvez également référencer du contenu web directement en commençant votre message par le symbole « # » suivi d’une URL. Par exemple, tapez « #https://fr.wikipedia.org/wiki/Intelligence_artificielle » puis posez votre question. Open WebUI récupère le contenu de la page web, l’analyse, et l’utilise comme contexte pour générer une réponse informée. Cette fonctionnalité fonctionne aussi avec les vidéos YouTube possédant des sous-titres. Référencez l’URL d’une vidéo YouTube, et Open WebUI extraira les sous-titres pour permettre au modèle de répondre à des questions sur le contenu de la vidéo.

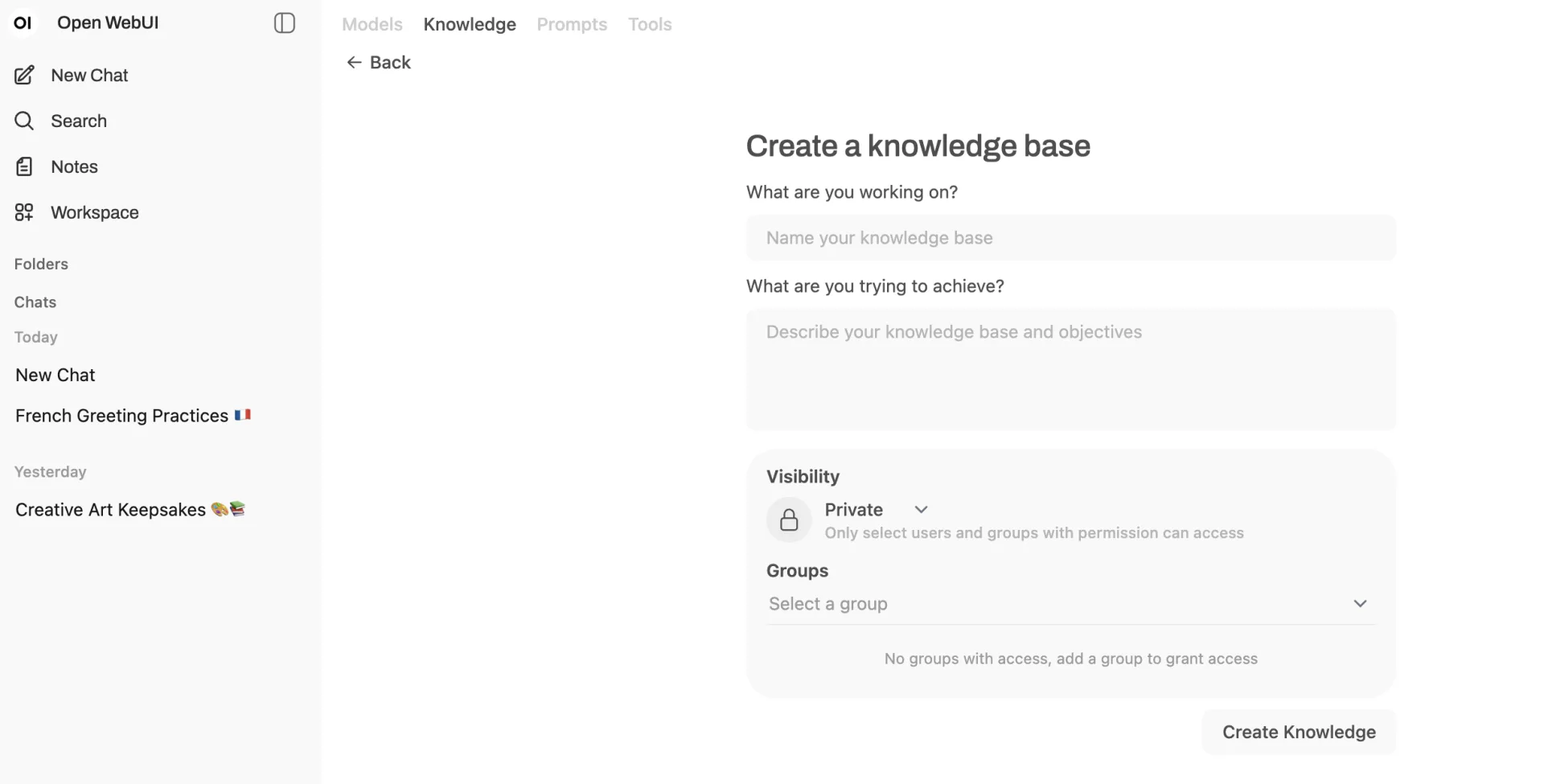

Pour une utilisation plus structurée du RAG, Open WebUI propose un système de « Knowledge » (bases de connaissance). Allez dans « Workspace » puis « Knowledge », et cliquez sur le bouton « + » pour créer une nouvelle base de connaissance. Donnez-lui un nom descriptif et une description, puis cliquez sur « Create Knowledge ». Vous pouvez ensuite charger plusieurs documents dans cette base en cliquant sur le bouton « + » à l’intérieur. Tous ces documents seront indexés et recherchables simultanément.

Une fois votre base de connaissance créée, vous pouvez l’associer à un modèle spécifique pour un accès rapide. Allez dans « Workspace » puis « Models », cliquez sur « + Add New Model », et dans la section « Knowledge Source », sélectionnez la base de connaissance que vous venez de créer. Donnez un nom à ce modèle personnalisé, puis sauvegardez. Désormais, lorsque vous sélectionnerez ce modèle dans une conversation, il aura automatiquement accès à tous les documents de la base de connaissance associée, sans que vous ayez besoin de les charger manuellement à chaque fois.

Open WebUI utilise par défaut le modèle d’embedding « all-MiniLM-L6-v2 » pour transformer vos documents en vecteurs recherchables. Pour des performances accrues ou un support multilingue amélioré, vous pouvez changer ce modèle dans les paramètres d’administration. Les modèles d’embedding plus volumineux offrent généralement une meilleure précision de recherche, mais consomment plus de ressources.

Un paramètre crucial pour optimiser le RAG est la taille du contexte (num_ctx) d’Ollama. Par défaut, Ollama utilise 2048 tokens de contexte, ce qui peut être insuffisant lorsque vous ajoutez du contenu externe via le RAG. Les pages web contiennent souvent 4000 à 8000 tokens même après extraction du contenu principal. Avec seulement 2048 tokens disponibles, le modèle ne peut traiter qu’une fraction du contenu récupéré. Pour optimiser le RAG, naviguez vers « Admin Panel > Models > Settings » (du modèle Ollama), puis « Advanced Parameters », et augmentez la longueur du contexte à 8192 tokens ou plus, idéalement 16000 pour les documents volumineux.

Open WebUI propose également une recherche hybride combinant la recherche vectorielle avec BM25 (un algorithme de recherche textuelle traditionnel), et un re-classement des résultats avec CrossEncoder pour améliorer la pertinence. Ces fonctionnalités avancées, activables dans les paramètres du document ou de la base de connaissance, affinent la précision du RAG et garantissent que les passages les plus pertinents sont fournis au modèle.

Fonctionnalités avancées

Au-delà de l’interface de chat et du RAG, Open WebUI offre des fonctionnalités avancées pour les utilisateurs expérimentés.

Le système de « Pipelines » permet d’étendre Open WebUI avec des logiques personnalisées. Les Pipelines sont des plugins Python qui s’exécutent entre l’utilisateur et le modèle, permettant de transformer les requêtes, de filtrer les réponses, ou d’ajouter des fonctionnalités entièrement nouvelles. Vous pouvez créer des Pipelines pour limiter le taux d’utilisation par utilisateur, monitorer l’usage avec des outils comme Langfuse, traduire automatiquement les messages avec LibreTranslate, filtrer les messages toxiques, ou intégrer des agents AI complexes. Les Pipelines s’installent directement depuis le panneau d’administration, dans « Settings > Pipelines ».

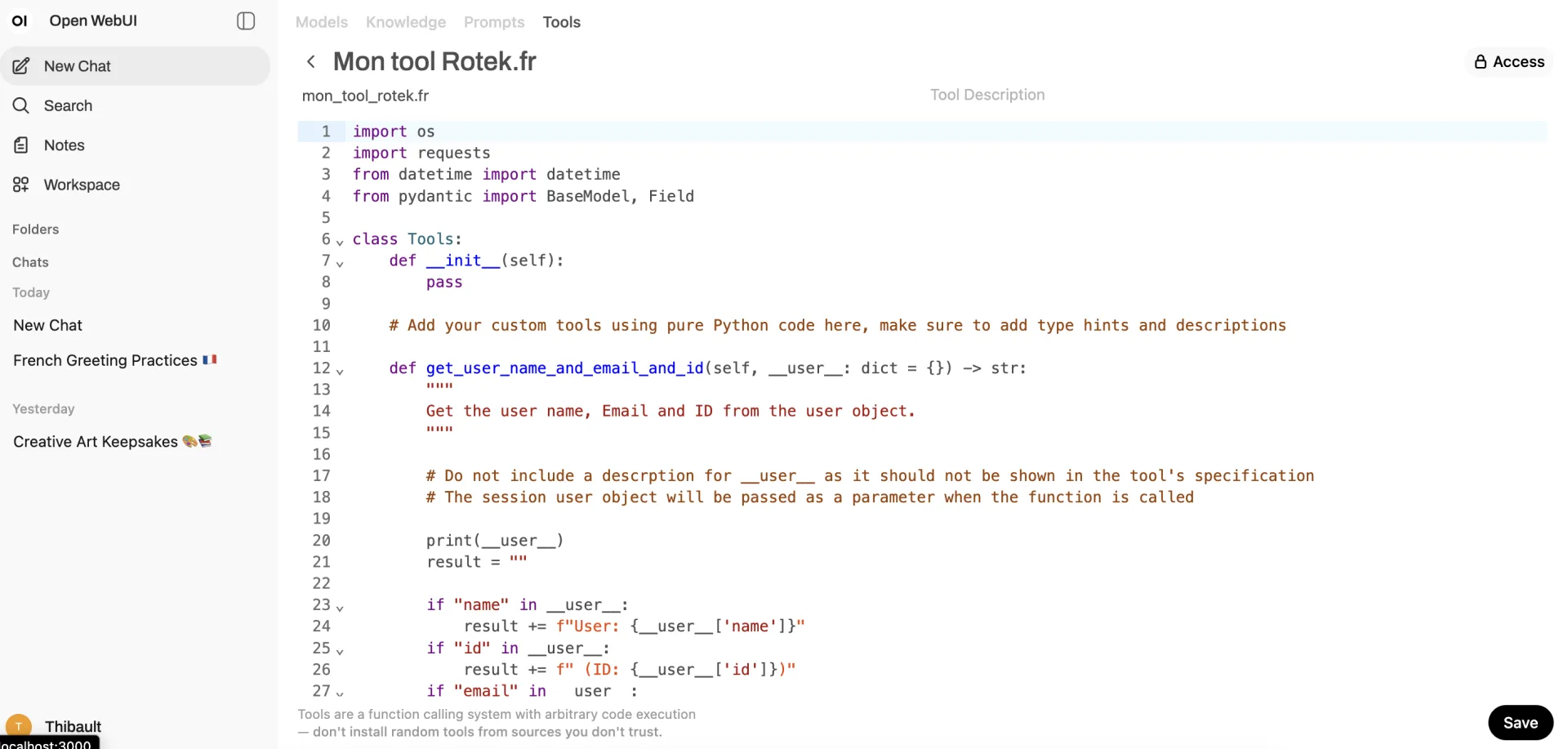

Le « Function Calling » (appel de fonctions) permet aux modèles d’exécuter du code Python pendant une conversation. Allez dans « Workspace > Tools » pour accéder à l’éditeur de fonctions intégré. Vous pouvez écrire des fonctions Python personnalisées que les modèles compatibles pourront appeler automatiquement selon le contexte. Par exemple, créez une fonction qui récupère la météo actuelle, calcule des statistiques sur des données, ou interagit avec une API externe. Lorsqu’un utilisateur pose une question nécessitant cette fonction, le modèle la détecte et l’exécute automatiquement, puis utilise le résultat pour formuler sa réponse.

Open WebUI supporte le fine-tuning (ajustement fin) de modèles directement depuis l’interface, permettant de personnaliser un modèle sur vos propres données sans ligne de commande. Cette fonctionnalité avancée nécessite des ressources GPU substantielles et des données d’entraînement de qualité, mais offre la possibilité de créer des modèles véritablement spécialisés pour vos cas d’usage.

La génération d’images peut être intégrée à Open WebUI en connectant un service comme Stable Diffusion WebUI. Une fois configuré, les utilisateurs peuvent demander la génération d’images directement dans leurs conversations, et Open WebUI affiche les images générées inline. Cette intégration multimodale enrichit considérablement les possibilités créatives.

Pour les environnements professionnels, Open WebUI supporte SCIM 2.0 (System for Cross-domain Identity Management), permettant une intégration avec des fournisseurs d’identité comme Okta, Azure AD, ou Google Workspace. Cette fonctionnalité automatise la gestion des utilisateurs et des groupes, synchronisant automatiquement les comptes et les permissions entre votre système d’identité d’entreprise et Open WebUI.

Open WebUI propose également une API REST complète, documentée dans la section « Documentation » du panneau d’administration. Cette API permet d’intégrer Open WebUI dans vos workflows automatisés, vos applications personnalisées, ou vos scripts. Vous pouvez envoyer des messages programmatiquement, récupérer l’historique des conversations, gérer les utilisateurs, ou accéder aux bases de connaissance via des appels API standards.

Gérer les utilisateurs et les permissions dans Open WebUI

La gestion multi-utilisateurs d’Open WebUI la rend adaptée aux déploiements en équipe ou en entreprise.

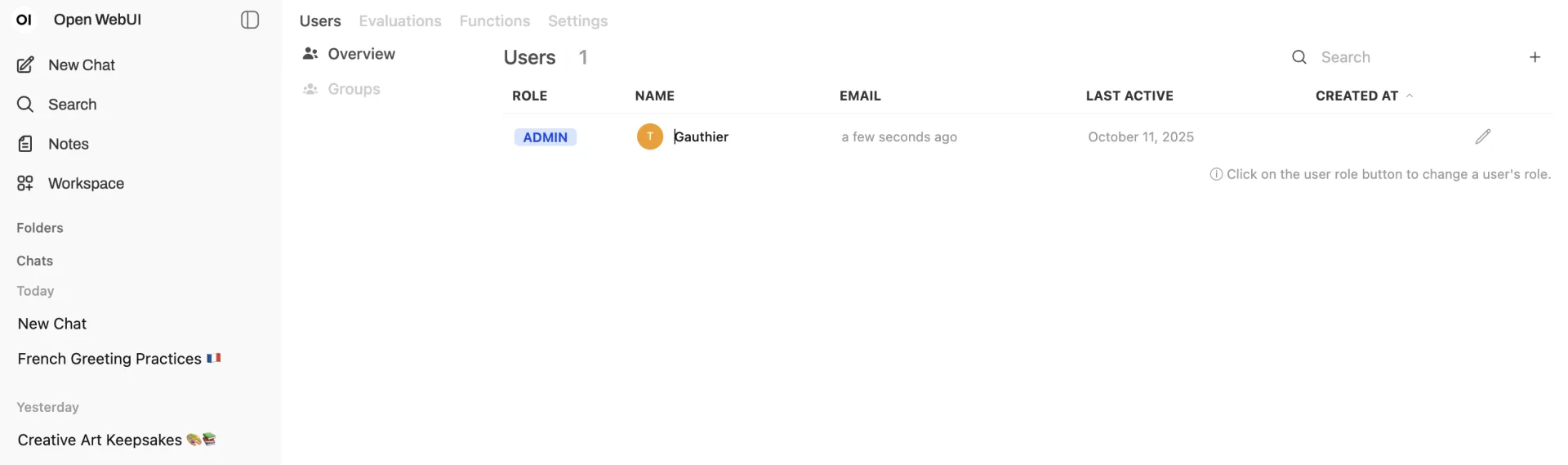

En tant qu’administrateur, vous pouvez créer de nouveaux comptes utilisateurs depuis le panneau d’administration. Allez dans « Admin Panel > Users » et cliquez sur « + Add User ». Renseignez un nom d’utilisateur, une adresse email et un mot de passe initial. Vous pouvez également définir le rôle de l’utilisateur lors de la création.

Open WebUI propose plusieurs rôles prédéfinis avec des niveaux de permission différents. Le rôle « Admin » dispose de tous les privilèges, incluant la gestion des utilisateurs, la configuration système, et l’accès à tous les modèles. Le rôle « User » permet d’utiliser Open WebUI normalement mais sans accès aux fonctions d’administration. Des rôles intermédiaires peuvent être créés pour des cas d’usage spécifiques, comme des modérateurs qui peuvent gérer le contenu mais pas les utilisateurs.

Les permissions granulaires permettent de contrôler précisément ce que chaque utilisateur ou groupe peut faire. Vous pouvez restreindre l’accès à certains modèles, limiter la taille des fichiers uploadés, désactiver certaines fonctionnalités comme le RAG ou la génération d’images, ou définir des quotas d’utilisation. Ces contrôles s’avèrent particulièrement utiles dans des contextes éducatifs ou professionnels où différents groupes d’utilisateurs ont des besoins différents.

Open WebUI supporte les groupes d’utilisateurs, facilitant la gestion des permissions pour des équipes entières. Créez un groupe, ajoutez-y des utilisateurs, puis définissez des permissions au niveau du groupe. Tous les membres héritent automatiquement de ces permissions. Par exemple, créez un groupe « Développeurs » avec accès aux modèles de code, et un groupe « Rédacteurs » avec accès aux modèles généralistes.

La fonctionnalité de partage de conversations permet aux utilisateurs de partager leurs discussions avec d’autres membres de l’instance Open WebUI. Chaque conversation possède une option « Share », générant un lien que vous pouvez envoyer à vos collègues. Les permissions de partage peuvent être configurées pour contrôler qui peut voir, copier, ou continuer les conversations partagées.

Sécuriser et optimiser votre instance Open WebUI

Pour un déploiement en production, plusieurs aspects de sécurité et d’optimisation méritent attention.

Si vous exposez Open WebUI sur internet ou sur un réseau d’entreprise, configurez HTTPS pour chiffrer les communications. La méthode recommandée utilise un reverse proxy comme Nginx ou Caddy devant Open WebUI. Installez Certbot pour obtenir des certificats SSL gratuits depuis Let’s Encrypt, configurez Nginx pour terminer le SSL et transférer les requêtes vers Open WebUI sur le port 3000 (ou 8080). Cette configuration protège les données en transit et évite que des mots de passe ou des conversations sensibles circulent en clair sur le réseau.

Définissez une politique de mots de passe robuste dans les paramètres d’administration. Exigez une longueur minimale, la présence de caractères spéciaux, et activez la double authentification (2FA) si votre instance Open WebUI la supporte via des Pipelines spécifiques.

Pour les déploiements Docker, utilisez des volumes Docker pour persister vos données plutôt que de stocker les informations directement dans le conteneur. La commande d’installation recommandée inclut déjà ce paramètre avec -v open-webui:/app/backend/data. Effectuez des sauvegardes régulières de ce volume pour éviter toute perte de données. Sur un système Linux, le volume se trouve généralement dans /var/lib/docker/volumes/open-webui/.

Surveillez la consommation de ressources de votre instance, particulièrement si plusieurs utilisateurs l’utilisent simultanément. Open WebUI lui-même est léger, mais l’exécution de modèles Ollama consomme RAM et GPU. Utilisez docker stats pour monitorer l’utilisation des ressources par vos conteneurs, ou des outils système comme htop et nvidia-smi pour les ressources globales.

Pour améliorer les performances, envisagez d’augmenter les ressources allouées à votre base de données si vous avez de nombreux utilisateurs. Par défaut, Open WebUI utilise SQLite, ce qui convient pour des petites installations. Pour des déploiements plus importants, passez à PostgreSQL en installant Open WebUI avec pip install open-webui[all] et en configurant la connexion PostgreSQL via les variables d’environnement.

Open WebUI propose désormais le support de Redis pour le stockage des sessions OAuth, particulièrement utile pour les déploiements multi-réplicas où plusieurs instances Open WebUI doivent partager l’état des sessions. Activez cette fonctionnalité expérimentale avec la variable d’environnement ENABLE_STAR_SESSIONS_MIDDLEWARE.

Pour limiter la charge sur votre serveur, implémentez des quotas d’utilisation via les Pipelines. Vous pouvez créer un Pipeline qui limite le nombre de requêtes par utilisateur et par heure, évitant qu’un utilisateur monopolise les ressources disponibles.

Mettre à jour Open WebUI

Les mises à jour régulières d’Open WebUI apportent de nouvelles fonctionnalités, des corrections de bugs et des améliorations de sécurité.

Pour mettre à jour une installation Docker, la méthode la plus simple utilise Watchtower, un outil qui surveille et met à jour automatiquement vos conteneurs Docker. Exécutez cette commande pour mettre à jour manuellement Open WebUI :

bash

docker run --rm -v /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webuiCette commande télécharge la dernière image d’Open WebUI, arrête l’ancien conteneur, et lance un nouveau conteneur avec la version mise à jour. Vos données sont préservées car elles sont stockées dans un volume Docker persistant.

Alternativement, vous pouvez mettre à jour manuellement en arrêtant le conteneur avec docker stop open-webui, en supprimant l’ancien conteneur avec docker rm open-webui, puis en relançant la commande d’installation initiale qui téléchargera automatiquement la dernière version.

Pour une installation Python avec pip, mettez à jour avec :

bash

pip install --upgrade open-webuiOu avec uv :

bash

uvx --python 3.11 open-webui@latest serveAprès chaque mise à jour, vérifiez que tout fonctionne correctement en vous connectant à Open WebUI et en testant les fonctionnalités principales. Consultez les notes de version sur le dépôt GitHub d’Open WebUI pour connaître les changements et les éventuelles incompatibilités.

Open WebUI vs alternatives : quelle interface choisir

Open WebUI n’est pas la seule interface pour interagir avec des modèles d’IA locaux, mais elle présente des avantages distincts.

Face à LM Studio, qui offre également une interface graphique pour les modèles locaux, Open WebUI se distingue par son architecture web qui permet l’accès depuis n’importe quel appareil du réseau. LM Studio reste une application de bureau excellente pour un usage personnel avec une interface intuitive et une gestion simplifiée des modèles, mais Open WebUI convient mieux aux déploiements multi-utilisateurs et aux environnements professionnels. Open WebUI offre également des fonctionnalités plus avancées comme le RAG structuré, les Pipelines personnalisés, et l’intégration de multiples backends simultanément.

Par rapport à Ollama en ligne de commande, Open WebUI apporte évidemment un confort d’utilisation considérable pour les utilisateurs non techniques. L’historique persistant des conversations, la capacité à basculer facilement entre modèles, et l’interface visuelle pour le RAG constituent des avantages majeurs. Cependant, la ligne de commande reste plus rapide pour des tests ponctuels ou des scripts automatisés. Les deux approches sont complémentaires plutôt que concurrentes.

D’autres interfaces web comme Chatbot UI ou Text Generation WebUI (oobabooga) offrent des alternatives à Open WebUI. Chatbot UI privilégie la simplicité et la légèreté, idéale pour un usage personnel basique. Text Generation WebUI excelle dans la configuration fine des paramètres de génération et supporte un plus grand nombre de formats de modèles, mais son interface peut sembler plus technique. Open WebUI trouve un équilibre entre richesse fonctionnelle et accessibilité.

Les interfaces commerciales comme ChatGPT ou Claude offrent des modèles plus puissants et une latence plus faible, mais au prix de la confidentialité et avec des coûts récurrents. Open WebUI permet de bénéficier d’une expérience similaire tout en gardant le contrôle total de vos données et sans frais d’utilisation au-delà de vos coûts d’infrastructure.

Le choix dépend finalement de vos priorités : simplicité et usage personnel favorisent LM Studio, contrôle maximum et personnalisation avancée orientent vers Text Generation WebUI, tandis que déploiement professionnel et multi-utilisateurs avec une interface moderne font d’Open WebUI le choix optimal.

Cas d’usage en entreprise

Open WebUI trouve de nombreuses applications dans des contextes professionnels et éducatifs.

Pour les équipes de développement, Open WebUI avec des modèles spécialisés comme CodeLlama ou DeepSeek Coder devient un assistant de programmation partagé. Créez une base de connaissance contenant votre documentation technique interne, vos standards de code, et vos guides d’architecture. Les développeurs peuvent ensuite interroger cette base pour comprendre rapidement comment implémenter une fonctionnalité selon vos pratiques spécifiques. La fonction de partage de conversations permet aux membres de l’équipe de partager des solutions trouvées avec l’IA.

Dans le secteur juridique ou de la conformité, la confidentialité absolue d’Open WebUI permet d’analyser des documents sensibles sans risque de fuite. Chargez des contrats, des réglementations ou des cas juridiques dans une base de connaissance, puis interrogez l’IA pour identifier des clauses spécifiques, comparer des documents, ou obtenir des résumés. Les avocats peuvent utiliser Open WebUI pour préparer des argumentaires, rechercher des précédents dans leur base documentaire, ou rédiger des brouillons de documents.

Pour les services clients et support technique, Open WebUI peut être configuré avec une base de connaissance contenant vos guides de dépannage, FAQ, et documentation produit. Les agents de support l’utilisent pour trouver rapidement des réponses précises aux questions clients, garantissant des réponses cohérentes et réduisant le temps de résolution. La gestion des permissions permet de donner accès au système à l’ensemble de l’équipe support tout en réservant la modification de la base de connaissance aux administrateurs.

Dans l’éducation, les établissements peuvent déployer Open WebUI pour leurs étudiants et enseignants, créant un assistant éducatif privé. Chargez des cours, des manuels, et des ressources pédagogiques dans des bases de connaissance par matière ou par niveau. Les étudiants posent des questions sur leur cours et obtiennent des explications adaptées, tandis que les enseignants utilisent l’IA pour générer des exercices, corriger des devoirs avec assistance, ou créer du contenu pédagogique. Les permissions granulaires permettent de contrôler l’accès selon les classes ou les groupes.

Pour la recherche et l’analyse, Open WebUI facilite l’exploration de grandes quantités de documents. Les chercheurs chargent des articles scientifiques, des rapports, ou des données de recherche, puis utilisent l’IA pour identifier des tendances, synthétiser des informations, ou générer des hypothèses. La capacité multimodale permet également d’analyser des graphiques, des schémas, ou des images présentes dans les documents de recherche.

Dans le marketing et la création de contenu, Open WebUI assiste les équipes créatives dans la génération d’idées, la rédaction de contenus, ou l’adaptation de messages pour différentes audiences. Créez des modèles personnalisés avec les guidelines de votre marque, votre ton de communication, et vos messages clés. L’équipe marketing peut alors générer des variations de contenus cohérentes avec votre identité de marque, tout en gardant le contrôle total sur les informations stratégiques utilisées.

Résoudre les problèmes courants avec Open WebUI

Malgré sa relative stabilité, vous pourriez rencontrer certains problèmes avec Open WebUI.

Si Open WebUI ne parvient pas à se connecter à Ollama, vérifiez d’abord que le service Ollama fonctionne. Sur votre machine hôte, testez l’accès à l’API Ollama avec curl http://localhost:11434/api/tags. Si cette commande échoue, Ollama n’est pas démarré correctement. Relancez-le selon votre système d’exploitation. Si la commande fonctionne depuis l’hôte mais pas depuis Open WebUI dans Docker, le problème vient probablement de la configuration réseau. Assurez-vous d’avoir utilisé --add-host=host.docker.internal:host-gateway dans votre commande Docker. Sur Linux, vous pouvez également essayer --network=host pour que le conteneur partage le réseau de l’hôte, simplifiant la connectivité.

Si le chargement de conversations devient lent ou si l’interface semble figée, cela peut indiquer un problème de base de données. SQLite, utilisé par défaut, peut ralentir avec un historique volumineux. Envisagez de migrer vers PostgreSQL pour de meilleures performances. Vous pouvez également nettoyer régulièrement l’historique en supprimant les anciennes conversations inutiles.

Si les fichiers uploadés pour le RAG ne sont pas correctement traités, vérifiez le format du fichier. Open WebUI supporte de nombreux formats, mais certains PDF complexes ou fichiers corrompus peuvent échouer. Essayez de convertir votre document dans un format plus simple (texte brut ou Markdown) pour vérifier si le problème vient du parser. Consultez également les logs d’Open WebUI pour identifier l’erreur spécifique : docker logs open-webui pour une installation Docker, ou les logs console pour une installation native.

Si certains modèles Ollama n’apparaissent pas dans la liste d’Open WebUI, rafraîchissez la connexion en allant dans « Admin Panel > Settings > Connections » et en cliquant sur l’icône de test à côté de l’URL Ollama. Cela force Open WebUI à re-synchroniser la liste des modèles disponibles.

Si Open WebUI affiche une erreur lors de l’authentification OAuth ou SCIM, vérifiez que la variable d’environnement WEBUI_SECRET_KEY est correctement définie et n’a pas changé entre les redémarrages. Un changement de cette clé invalide les sessions existantes et peut causer des erreurs de déchiffrement. Définissez cette clé de manière permanente via un fichier .env ou les variables d’environnement Docker.

Si les utilisateurs se plaignent de réponses incohérentes ou tronquées avec le RAG, le problème vient probablement d’un contexte insuffisant. Augmentez le paramètre num_ctx d’Ollama à au moins 8192 tokens. Vérifiez également que les documents chargés sont correctement indexés en consultant la section Documents du Workspace.

Questions fréquentes

Oui, il peut fonctionner avec d’autres backends compatibles OpenAI comme LM Studio, des API cloud (OpenAI, Anthropic, Mistral AI), ou des déploiements personnalisés. Configurez simplement l’URL de l’API dans les paramètres de connexion. Cependant, l’intégration avec Ollama reste la plus transparente et la mieux supportée.

Oui, c’est une application web responsive qui fonctionne sur les navigateurs mobiles. Sur Android, Open WebUI supporte également la fonctionnalité Progressive Web App (PWA), permettant de l’installer comme une application native avec support du menu de partage système. Vous pouvez ainsi partager des pages web, des vidéos YouTube, ou du texte directement vers l’interfance depuis d’autres applications.

Absolument. Avec une installation locale d’Open WebUI connectée à Ollama local, toutes vos données restent sur votre infrastructure. Aucune information n’est envoyée vers des serveurs externes. Pour une confidentialité maximale, ne connectez pas Open WebUI à des API cloud et assurez-vous que votre instance n’est pas accessible depuis internet sans authentification.

Cela dépend principalement de vos ressources serveur, particulièrement la RAM et le GPU pour exécuter les modèles Ollama. Chaque utilisateur actif consommant un modèle nécessite que ce modèle soit chargé en mémoire. Pour supporter de nombreux utilisateurs simultanés, envisagez d’utiliser des modèles plus légers ou de déployer plusieurs instances Ollama sur différentes machines que vous répartissez via un load balancer.

Pour une installation Docker, sauvegardez le volume Docker avec docker run --rm -v open-webui:/data -v $(pwd):/backup ubuntu tar czf /backup/open-webui-backup.tar.gz -C /data .. Cette commande crée une archive de toutes vos données. Pour restaurer, créez un nouveau volume et extrayez l’archive dedans. Pour une installation native, sauvegardez simplement le répertoire défini dans DATA_DIR.

Pour de nombreux cas d’usage, oui. Il offre des fonctionnalités similaires (conversations, historique, partage, RAG) avec l’avantage de la confidentialité totale et sans coûts récurrents. Cependant, les modèles open source disponibles via Ollama, bien que très capables, n’égalent pas encore systématiquement les performances de GPT-4 ou Claude Opus sur les tâches les plus complexes. L’approche idéale consiste souvent à utiliser Open WebUI pour les tâches courantes et les données sensibles, en complément d’une API cloud pour les cas nécessitant les capacités maximales.