Vous souhaitez utiliser des modèles d’intelligence artificielle sans dépendre de services cloud payants et en gardant le contrôle total de vos données ? Ollama représente une solution particulièrement intéressante pour exécuter des modèles de langage (LLM) directement sur votre machine. Cet outil open source simplifie l’installation et l’utilisation de modèles comme Llama, Mistral ou Gemma, en offrant une alternative locale aux API commerciales. Dans ce guide complet, vous découvrirez comment installer et utiliser Ollama pour bénéficier d’une intelligence artificielle privée et gratuite.

- Qu'est-ce qu'Ollama et pourquoi l'utiliser

- Configuration matérielle recommandée pour Ollama

- Installation d'Ollama sur différents systèmes d'exploitation

- Télécharger et lancer votre premier modèle Ollama

- Commandes essentielles pour gérer vos modèles Ollama

- Personnaliser vos modèles avec les Modelfiles

- Optimiser les performances d'Ollama

- Utiliser l'API REST pour l'intégration dans vos applications

- Intégrer Ollama dans un système RAG (Retrieval-Augmented Generation)

- Cas d'usage

- Résoudre les problèmes courants avec Ollama

- Ollama face aux alternatives : quand choisir une solution locale

- Questions fréquentes

Qu’est-ce qu’Ollama et pourquoi l’utiliser

Ollama est un framework open source conçu pour faciliter l’exécution de modèles de langage de grande taille sur votre ordinateur personnel. Contrairement aux solutions basées sur le cloud comme ChatGPT ou Claude, Ollama vous permet de faire fonctionner ces modèles directement sur votre matériel, sans connexion internet ni frais d’utilisation récurrents. Il peut également servir de base à des projets de fine tuning locaux, permettant d’entraîner vos propres variantes de modèles open source sans dépendre de serveurs distants.

L’intérêt principal d’Ollama réside dans sa capacité à rendre accessible des modèles d’IA performants tout en préservant la confidentialité de vos données. Vos conversations, documents et requêtes restent strictement sur votre machine, ce qui constitue un avantage considérable pour les professionnels manipulant des informations sensibles ou confidentielles. Cette approche locale élimine également les risques liés au partage de données avec des services tiers.

Au-delà de la confidentialité, Ollama offre plusieurs avantages pratiques. Une fois les modèles téléchargés, vous pouvez les utiliser sans connexion internet, ce qui garantit une disponibilité constante. L’outil prend en charge une bibliothèque riche de modèles incluant Llama 3.2 et 3.3, Mistral, Gemma, Phi, DeepSeek-R1 et bien d’autres, avec des tailles variant de 1 milliard à plus de 400 milliards de paramètres. L’absence de coûts récurrents constitue également un atout financier, même si vous devrez considérer la consommation électrique de votre matériel.

Configuration matérielle recommandée pour Ollama

Avant d’installer Ollama, vous devez vérifier que votre système dispose des ressources suffisantes. Les exigences matérielles varient considérablement selon la taille du modèle que vous souhaitez utiliser.

Pour la mémoire vive (RAM), comptez environ 8 Go pour les modèles de 7 milliards de paramètres, 16 Go pour les modèles de 13 milliards de paramètres, et au minimum 32 Go pour les modèles de 33 milliards de paramètres. Cette RAM est essentielle car le modèle doit être chargé intégralement en mémoire pour fonctionner correctement. Une règle approximative consiste à prévoir environ 1 Go de RAM par milliard de paramètres pour les modèles quantifiés en 4 bits, et davantage pour les versions moins compressées.

Concernant le processeur, un CPU moderne avec au moins 4 cœurs constitue le minimum acceptable. Cependant, pour une expérience fluide, privilégiez un processeur récent à 8 cœurs ou plus, comme un AMD Ryzen 7 ou un Intel Core i7. Les processeurs Apple Silicon (M1, M2, M3) offrent d’excellentes performances pour Ollama grâce à leur architecture unifiée qui combine CPU, GPU et mémoire.

L’accélération GPU améliore considérablement les performances d’Ollama. Une carte graphique NVIDIA avec au moins 8 Go de VRAM (comme une RTX 3060 ou supérieure) permet d’obtenir des temps de réponse beaucoup plus rapides qu’avec le CPU seul. Les GPU AMD sont également supportés via ROCm, bien que le support NVIDIA reste plus mature. Sur Mac, les puces Apple Silicon exploitent automatiquement l’accélération matérielle sans configuration supplémentaire. Si vous n’avez pas de GPU dédié, Ollama fonctionnera avec le CPU, mais les performances seront nettement plus lentes, particulièrement pour les modèles volumineux.

Pour le stockage, prévoyez au minimum 50 Go d’espace libre sur votre disque dur. Les modèles varient de quelques gigaoctets pour les plus petits (comme Llama 3.2 1B qui pèse environ 1,3 Go) à plus de 200 Go pour les modèles géants (comme Llama 3.1 405B qui nécessite environ 231 Go). Un SSD NVMe accélère significativement le chargement des modèles, réduisant le temps d’attente avant de pouvoir utiliser l’IA.

Installation d’Ollama sur différents systèmes d’exploitation

L’installation d’Ollama varie légèrement selon votre système d’exploitation, mais reste simple dans tous les cas.

Sur Windows, Ollama supporte nativement Windows 10 version 22H2 et les versions ultérieures, ainsi que Windows 11 et Windows Server 2025. Vous pouvez installer Ollama de deux manières : soit en téléchargeant l’installeur officiel depuis le site ollama.com, soit en utilisant WinGet, le gestionnaire de paquets intégré à Windows 11 et Windows Server 2025. Pour l’installation via WinGet, ouvrez le terminal et exécutez simplement la commande winget install Ollama.Ollama. L’installation se déroule automatiquement et un installeur graphique apparaît brièvement à l’écran. Une fois l’installation terminée, fermez le terminal puis ouvrez-en un nouveau pour actualiser les variables d’environnement. Vous pouvez alors vérifier qu’Ollama fonctionne en tapant ollama --version dans ce nouveau terminal. Si la commande affiche un numéro de version, l’installation est réussie.

Sur macOS, l’installation est particulièrement simple. Téléchargez l’application Ollama depuis le site officiel, puis double-cliquez sur le fichier téléchargé pour l’installer dans votre dossier Applications. Lancez ensuite Ollama depuis le Finder. L’application se lance automatiquement et un terminal s’ouvre en arrière-plan pour gérer le serveur Ollama. Les utilisateurs de Homebrew peuvent également installer Ollama avec la commande brew install ollama. Pour vérifier que l’installation a réussi, ouvrez le Terminal et tapez ollama --version. Les Mac équipés de puces Apple Silicon (M1, M2, M3) bénéficient de performances optimales grâce à l’accélération matérielle native, qui exploite efficacement la mémoire unifiée de ces processeurs.

Pour Linux, l’installation se fait via un script automatisé. Ouvrez votre terminal et exécutez la commande curl -fsSL https://ollama.com/install.sh | sh. Ce script détecte automatiquement votre distribution et installe Ollama avec les dépendances nécessaires. La plupart des distributions modernes sont compatibles, avec une recommandation particulière pour Ubuntu 18.04, 22.04 ou versions ultérieures. Après l’installation, Ollama se lance automatiquement en tant que service système. Vous pouvez vérifier le statut du service avec systemctl status ollama, et si nécessaire le redémarrer avec sudo systemctl restart ollama.

Télécharger et lancer votre premier modèle Ollama

Une fois Ollama installé, vous pouvez commencer à télécharger et utiliser des modèles. La commande de base pour exécuter un modèle est ollama run suivie du nom du modèle.

Pour débuter, Llama 3.2 constitue un excellent choix grâce à son bon équilibre entre performance et taille. Ouvrez votre terminal et tapez ollama run llama3.2. Si c’est la première fois que vous utilisez ce modèle, Ollama le téléchargera automatiquement avant de le lancer. Le téléchargement peut prendre plusieurs minutes selon votre connexion internet et la taille du modèle. Une barre de progression affiche l’avancement du téléchargement.

Une fois le modèle chargé, une invite de commande interactive apparaît, précédée de trois chevrons >>>. Vous pouvez alors poser vos questions directement. Par exemple, en tapant « Explique-moi en quelques lignes comment fonctionne l’apprentissage automatique », le modèle génère une réponse détaillée en temps réel. Le texte s’affiche progressivement, mot par mot, simulant une conversation naturelle. Pour sortir de la session interactive et revenir au terminal normal, appuyez sur Ctrl+D (ou tapez /bye).

Ollama propose une bibliothèque riche de modèles adaptés à différents usages. Llama 3.2 existe en versions 1B et 3B paramètres, idéales pour les machines avec des ressources limitées. Llama 3.3 70B offre des performances similaires à Llama 3.1 405B tout en étant beaucoup plus léger, avec environ 43 Go contre 231 Go. Pour la génération de code, CodeLlama et DeepSeek Coder sont spécialement optimisés pour comprendre et produire du code dans différents langages de programmation. Mistral 7B se distingue par son efficacité et ses capacités de « function calling », qui permettent au modèle d’appeler des fonctions externes. Gemma 2, disponible en 2B, 9B et 27B paramètres, est développé par Google DeepMind et offre un excellent rapport performance-ressources. Phi-4, avec ses 14 milliards de paramètres, excelle dans les tâches de raisonnement complexe. Pour des besoins spécifiques comme l’analyse de données textuelles, QwQ propose des capacités de raisonnement avancées.

Pour consulter tous les modèles disponibles, vous pouvez visiter la bibliothèque sur ollama.com/library qui liste plusieurs centaines de modèles avec leurs descriptions et tailles. La commande ollama list affiche les modèles déjà téléchargés sur votre machine.

Commandes essentielles pour gérer vos modèles Ollama

Ollama offre plusieurs commandes pour gérer efficacement vos modèles locaux et optimiser leur utilisation.

La commande ollama pull permet de télécharger un modèle sans le lancer immédiatement. Par exemple, ollama pull mistral télécharge le modèle Mistral sans démarrer de session interactive. Cette approche s’avère utile pour préparer plusieurs modèles en avance, notamment si vous planifiez de travailler hors ligne ou si vous souhaitez télécharger plusieurs modèles pendant la nuit.

Pour voir la liste des modèles installés sur votre machine, utilisez ollama list. Cette commande affiche le nom, la taille et la date de dernière utilisation de chaque modèle sous forme de tableau. Vous pouvez ainsi voir rapidement combien d’espace disque occupe chaque modèle. Si vous manquez d’espace disque, ollama rm suivi du nom du modèle permet de supprimer un modèle téléchargé. Par exemple, ollama rm llama3.1:405b supprime le modèle Llama 3.1 de 405 milliards de paramètres et libère environ 231 Go.

La commande ollama show fournit des informations détaillées sur un modèle spécifique, notamment sa quantification (qui détermine la précision et la taille du modèle), ses paramètres par défaut et son template de prompt. Par exemple, ollama show llama3.2 affiche toutes les caractéristiques de ce modèle. Pour vérifier si un modèle est actuellement en cours d’exécution, utilisez ollama ps. Cette commande liste tous les modèles actifs en mémoire avec leur consommation de ressources.

Si vous avez besoin d’arrêter un modèle en cours d’exécution pour libérer de la mémoire, la commande ollama stop suivie du nom du modèle permet de le décharger. Par exemple, ollama stop mistral libère la RAM occupée par le modèle Mistral. Cette fonction s’avère particulièrement utile avant de charger un autre modèle volumineux, car elle évite de saturer la mémoire disponible.

Pour copier un modèle existant et créer une variante personnalisée, utilisez ollama cp. Cette commande est pratique lorsque vous souhaitez créer plusieurs versions d’un même modèle avec des paramètres différents sans avoir à re-télécharger le modèle de base.

Personnaliser vos modèles avec les Modelfiles

L’une des fonctionnalités avancées d’Ollama est la possibilité de personnaliser les modèles grâce aux Modelfiles. Un Modelfile est un fichier de configuration qui permet de définir le comportement d’un modèle, ses paramètres et son message système.

Pour créer un Modelfile personnalisé, créez un fichier texte nommé Modelfile (sans extension) dans un répertoire de votre choix. Dans ce fichier, vous pouvez spécifier plusieurs instructions. La directive FROM indique le modèle de base à utiliser, par exemple FROM llama3.2. La directive SYSTEM définit le message système qui conditionne le comportement du modèle. Par exemple, vous pourriez écrire SYSTEM "Tu es un assistant spécialisé en cybersécurité qui répond de manière concise et technique.". La directive PARAMETER permet d’ajuster les paramètres du modèle, comme PARAMETER temperature 0.8 pour augmenter la créativité des réponses.

Voici un exemple concret de Modelfile qui crée un assistant de programmation Python :

FROM codellama

PARAMETER temperature 0.3

PARAMETER num_ctx 4096

SYSTEM """

Tu es un expert en Python qui aide les développeurs à écrire du code propre et efficace.

Tu fournis toujours des exemples de code commentés et tu expliques les meilleures pratiques.

Tu es concis mais complet dans tes explications.

"""Une fois votre Modelfile créé, utilisez la commande ollama create pour générer votre modèle personnalisé. Par exemple, si votre Modelfile se trouve dans le répertoire courant, tapez ollama create python-expert -f Modelfile. Vous pouvez ensuite utiliser ce modèle avec ollama run python-expert. Cette personnalisation vous permet de créer des assistants spécialisés adaptés à vos besoins spécifiques, comme un relecteur de documentation technique, un assistant de traduction, ou un générateur de contenu marketing.

Optimiser les performances d’Ollama

Plusieurs paramètres permettent d’ajuster le comportement et les performances d’Ollama selon vos besoins et votre matériel.

La température contrôle la créativité des réponses. Une valeur proche de 0 produit des réponses plus déterministes et factuelles, tandis qu’une valeur proche de 1 génère des réponses plus variées et créatives. Pour des tâches nécessitant de la précision comme la génération de code ou l’analyse de données, utilisez une température basse (0.1 à 0.3). Pour des tâches créatives comme l’écriture de contenu ou le brainstorming, une température plus élevée (0.7 à 0.9) offre de meilleurs résultats.

Le paramètre num_ctx définit la taille de la fenêtre de contexte, c’est-à-dire la quantité d’informations que le modèle peut garder en mémoire simultanément. Par défaut, Ollama utilise 2048 tokens, ce qui peut limiter les performances pour certaines tâches. Un token représente approximativement trois quarts d’un mot en français. Pour des conversations plus longues ou l’analyse de documents volumineux, augmentez cette valeur à 4096, 8192 ou même 16000 tokens. Vous pouvez définir ce paramètre lors du lancement avec ollama run llama3.2 --num-ctx 8192. Attention : augmenter le contexte consomme davantage de mémoire vive.

Le paramètre top_p, également appelé « nucleus sampling », restreint le choix des mots aux options cumulant une probabilité totale donnée. Une valeur de 0.9 limite la sélection aux mots représentant 90% de la probabilité cumulée, ce qui équilibre diversité et cohérence dans les réponses.

L’accélération GPU peut être activée ou désactivée selon vos besoins. Sur les systèmes équipés de cartes NVIDIA, assurez-vous que les derniers drivers GeForce Game Ready ou NVIDIA Studio sont installés. Ollama détecte et utilise automatiquement le GPU disponible. Vous pouvez vérifier l’utilisation du GPU pendant l’exécution d’un modèle avec la commande nvidia-smi sur les systèmes équipés de cartes NVIDIA. Sur les Mac avec Apple Silicon, l’accélération est native et ne nécessite aucune configuration, la charge étant répartie intelligemment entre le CPU et le GPU intégrés.

Pour forcer Ollama à utiliser uniquement le CPU (par exemple pour tester les performances ou libérer le GPU pour d’autres applications), vous pouvez définir la variable d’environnement OLLAMA_NUM_GPU=0 avant de lancer Ollama.

Utiliser l’API REST pour l’intégration dans vos applications

Pour les utilisateurs avancés et les développeurs, Ollama expose une API REST sur le port 11434. Cette API permet d’intégrer Ollama dans vos applications, scripts ou workflows personnalisés.

L’endpoint principal pour la génération de texte est /api/generate. Vous pouvez envoyer une requête POST à http://localhost:11434/api/generate avec un corps JSON contenant le nom du modèle et votre prompt. Par exemple, avec curl :

bash

curl -X POST http://localhost:11434/api/generate -d '{

"model": "llama3.2",

"prompt": "Pourquoi le ciel est-il bleu ?",

"stream": false

}'Le paramètre stream détermine si la réponse est renvoyée en streaming (mot par mot) ou en une seule fois. Pour les interfaces utilisateur interactives, le streaming offre une meilleure expérience.

L’endpoint /api/chat permet de maintenir une conversation avec historique. Vous pouvez envoyer une liste de messages (utilisateur et assistant) et le modèle génère une réponse en tenant compte du contexte complet de la conversation.

L’API propose également des endpoints pour gérer les modèles : /api/tags liste tous les modèles disponibles localement, /api/pull télécharge un nouveau modèle, /api/push partage un modèle personnalisé, et /api/delete supprime un modèle.

Pour Python, vous pouvez utiliser la bibliothèque requests pour interagir avec l’API, ou des bibliothèques spécialisées comme litellm ou langchain qui offrent des abstractions de plus haut niveau et facilitent l’intégration d’Ollama dans des applications d’IA plus complexes.

Intégrer Ollama dans un système RAG (Retrieval-Augmented Generation)

Ollama peut également servir de moteur de génération dans un pipeline RAG, une approche qui combine la recherche d’informations dans vos propres données et la génération de texte par l’IA. Concrètement, le RAG consiste à enrichir les réponses d’un modèle de langage avec des connaissances issues de vos documents internes, bases de données ou fichiers PDF.

Grâce à son API REST locale, Ollama peut être couplé à des outils comme LangChain, LlamaIndex ou Haystack pour créer un assistant conversationnel privé capable d’exploiter vos propres données sans passer par le cloud. Cette approche permet de construire un assistant de documentation interne ou un chatbot d’entreprise confidentiel en toute autonomie.

Cas d’usage

Ollama s’adapte à de nombreux scénarios d’utilisation professionnels et personnels, offrant une flexibilité considérable.

Pour l’assistance au développement, les modèles comme CodeLlama, DeepSeek Coder ou Qwen2.5-Coder excellent dans la génération, l’explication et la correction de code. Vous pouvez demander à Ollama de générer une fonction Python pour trier un tableau, d’expliquer un algorithme complexe, de débugger du code défectueux, ou de convertir du code d’un langage à un autre. Par exemple, ollama run codellama "Écris une fonction Python qui implémente l'algorithme de tri rapide" génère du code commenté et fonctionnel.

Pour la rédaction et l’analyse de contenu, les modèles généralistes comme Llama 3.3 ou Mistral peuvent rédiger des articles, améliorer des textes existants, résumer des documents longs, ou traduire du contenu. Vous pouvez utiliser Ollama pour générer des descriptions de produits, créer des plans d’articles, ou reformuler du texte dans un style différent. La confidentialité garantie par le traitement local rend cette solution particulièrement adaptée pour les entreprises qui ne souhaitent pas partager leurs documents internes avec des services cloud tiers.

Pour l’apprentissage et la recherche, Ollama peut expliquer des concepts complexes, répondre à des questions techniques, ou servir d’assistant d’étude. Les étudiants peuvent l’utiliser pour comprendre des théories scientifiques, des formules mathématiques, ou des événements historiques. Par exemple, demander à Ollama d’expliquer la relativité générale comme si vous aviez 12 ans génère une explication accessible et pédagogique.

Pour l’analyse de données textuelles, vous pouvez utiliser Ollama pour extraire des informations structurées depuis du texte non structuré, catégoriser des documents, ou analyser le sentiment de textes. Les entreprises peuvent automatiser le traitement de retours clients, la classification d’emails, ou l’extraction d’informations depuis des rapports.

Pour les tâches multimodales, certains modèles Ollama comme Llama 3.2 Vision ou LLaVA peuvent analyser des images. Vous pouvez leur envoyer une capture d’écran et poser des questions sur son contenu, analyser des diagrammes, ou extraire du texte depuis des images. Cette capacité ouvre des possibilités intéressantes pour l’accessibilité, l’automatisation de workflows, ou l’analyse de documents scannés.

Résoudre les problèmes courants avec Ollama

Même avec une installation correcte, vous pourriez rencontrer certains problèmes lors de l’utilisation d’Ollama. Voici les solutions aux situations les plus fréquentes.

Si vous obtenez une erreur « Out of memory » ou si votre système plante lors du chargement d’un modèle, cela signifie que le modèle est trop volumineux pour votre RAM disponible. Fermez les autres applications pour libérer de la mémoire, essayez une version plus petite du modèle (par exemple Llama 3.2 1B au lieu de 3B), ou choisissez un modèle avec une quantification plus agressive. Les modèles quantifiés en Q4 (4 bits) sont beaucoup plus légers que les versions Q8 ou F16.

Si les réponses du modèle sont anormalement lentes, vérifiez d’abord que votre GPU est correctement détecté et utilisé. Sur les systèmes NVIDIA, utilisez nvidia-smi pendant qu’Ollama génère une réponse pour voir si le GPU est sollicité. Si le GPU n’est pas utilisé, réinstallez les derniers drivers graphiques. Sur Mac, assurez-vous d’utiliser une version récente d’Ollama optimisée pour Apple Silicon. Vous pouvez également réduire la taille du contexte (num_ctx) si vous l’aviez augmentée, car un contexte plus grand ralentit la génération.

Si Ollama refuse de démarrer ou affiche une erreur « connection refused », vérifiez qu’aucun autre processus n’utilise le port 11434. Sur Linux, utilisez sudo lsof -i :11434 pour identifier le processus. Sur Windows et Mac, vérifiez qu’aucune autre instance d’Ollama n’est en cours d’exécution en arrière-plan. Redémarrer le service Ollama résout généralement ce problème : sur Linux avec sudo systemctl restart ollama, et sur Windows/Mac en fermant complètement l’application puis en la relançant.

Si un modèle génère des réponses incohérentes ou répétitives, ajustez les paramètres de génération. Réduisez la température pour des réponses plus cohérentes, ou augmentez top_p pour plus de diversité. Le paramètre repeat_penalty (valeur par défaut 1.1) pénalise la répétition de tokens et peut être augmenté à 1.2 ou 1.3 pour réduire les répétitions.

Si le téléchargement d’un modèle échoue ou s’interrompt, Ollama reprend automatiquement le téléchargement là où il s’était arrêté lorsque vous relancez la commande ollama pull. Si le problème persiste, vérifiez votre connexion internet et l’espace disque disponible.

Ollama face aux alternatives : quand choisir une solution locale

Ollama n’est pas le seul outil pour exécuter des modèles d’IA en local, mais il présente des avantages distincts par rapport aux alternatives.

Si vous cherchez une interface graphique avec de nombreuses fonctionnalité en complément, découvrez Open WebUI, l’interface web intuitive pour vos IA locales.

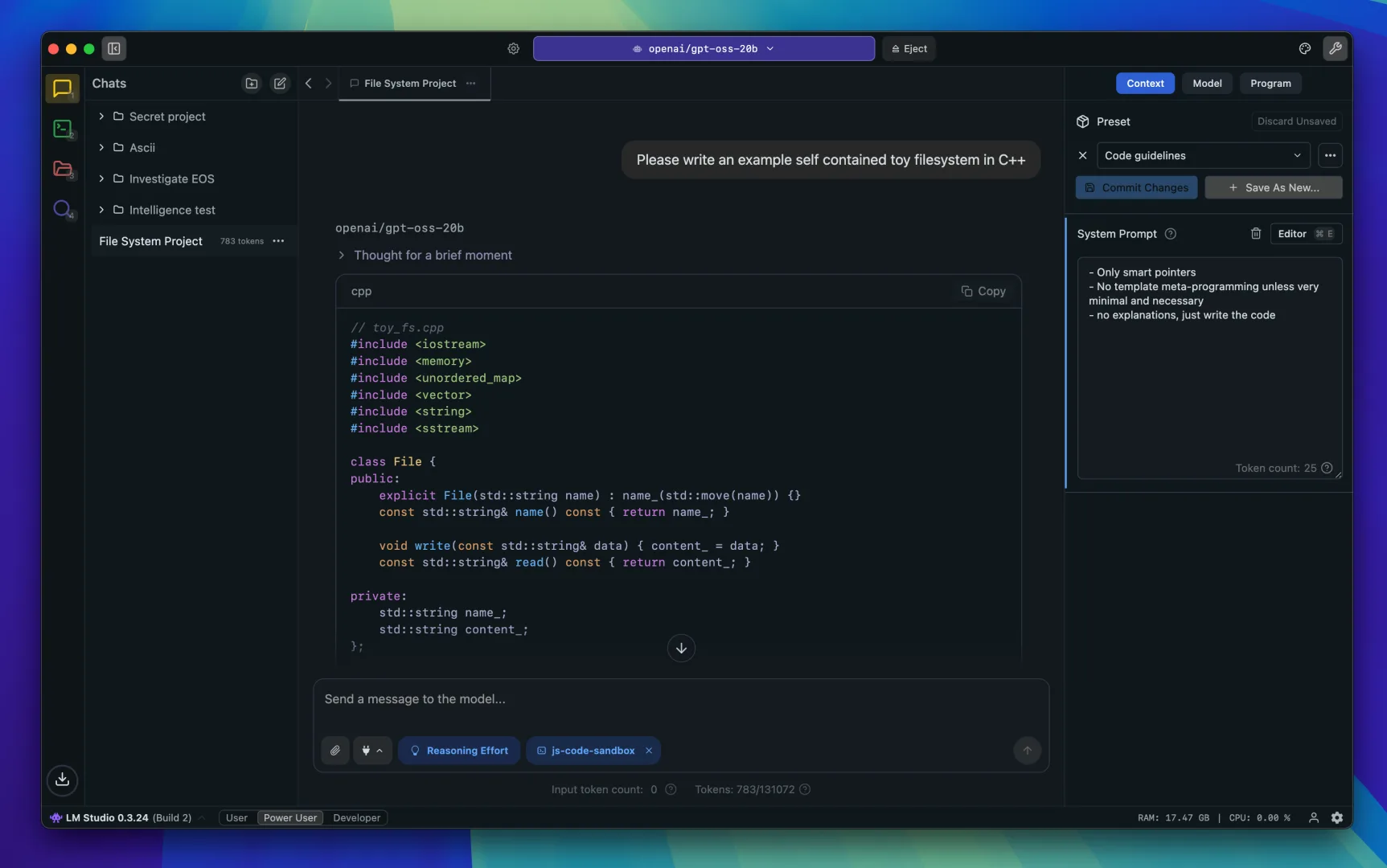

Par rapport à LM Studio, un autre outil populaire pour exécuter des LLM localement, Ollama se distingue par sa simplicité et son orientation ligne de commande. LM Studio offre une interface graphique complète et conviviale, idéale pour les utilisateurs moins techniques, tandis qu’Ollama privilégie l’automatisation et l’intégration dans des workflows. LM Studio permet de télécharger des modèles depuis Hugging Face plus facilement, mais Ollama offre une API REST plus mature pour l’intégration dans des applications.

Par rapport à llama.cpp, le projet sous-jacent sur lequel Ollama est construit, Ollama ajoute une couche de simplicité considérable. llama.cpp nécessite de compiler les modèles et de maîtriser des options de ligne de commande complexes, tandis qu’Ollama gère tout cela automatiquement. Pour les utilisateurs avancés recherchant le contrôle maximum et les meilleures performances possibles, llama.cpp reste préférable, mais Ollama offre un meilleur compromis entre facilité d’utilisation et performance pour la majorité des cas d’usage.

Par rapport aux API cloud comme OpenAI, Anthropic ou Google, Ollama présente des avantages et des inconvénients. Les API cloud offrent généralement des modèles plus puissants (comme GPT-4 ou Claude Opus), une latence plus faible sur des connexions rapides, et aucune contrainte matérielle. Cependant, Ollama garantit une confidentialité totale, fonctionne hors ligne, ne génère aucun coût d’utilisation récurrent, et permet une personnalisation complète des modèles. Pour des usages professionnels impliquant des données sensibles, la solution locale d’Ollama constitue souvent le meilleur choix.

Le choix entre Ollama et les solutions cloud dépend de vos priorités : confidentialité et coûts à long terme favorisent Ollama, tandis que performance maximale et simplicité d’accès favorisent les API cloud. De nombreuses organisations adoptent une approche hybride, utilisant Ollama pour le développement et les données sensibles, et des API cloud pour les fonctionnalités nécessitant les modèles les plus puissants.

Questions fréquentes

Oui, Ollama fonctionne parfaitement avec uniquement le CPU. Cependant, les performances seront significativement plus lentes, particulièrement pour les modèles volumineux. Un GPU NVIDIA ou AMD dédié, ou une puce Apple Silicon, améliore considérablement l’expérience. Pour une utilisation CPU uniquement, privilégiez les modèles plus petits comme Llama 3.2 1B ou Phi-4 Mini.

Le nombre suivi de « B » indique le nombre de milliards de paramètres du modèle. Plus ce nombre est élevé, plus le modèle est capable de comprendre des concepts complexes et de générer des réponses précises, mais plus il nécessite de ressources (RAM, VRAM) et plus il est lent à exécuter. Un modèle 7B convient pour la plupart des tâches courantes, tandis qu’un modèle 70B excelle dans les tâches complexes nécessitant un raisonnement approfondi.

Cela dépend de vos besoins. Pour des tâches impliquant des données confidentielles, Ollama offre un avantage majeur en garantissant que vos données restent locales. Pour des tâches nécessitant les capacités les plus avancées, les modèles commerciaux comme GPT-4 restent supérieurs aux modèles open source disponibles sur Ollama. De nombreuses entreprises utilisent Ollama pour le développement et les données sensibles, complété par des API cloud pour les cas d’usage nécessitant des capacités maximales.

Sur Windows avec WinGet, utilisez winget upgrade Ollama.Ollama. Sur macOS, téléchargez la dernière version depuis le site officiel et installez-la par-dessus l’ancienne, ou utilisez brew upgrade ollama si vous l’aviez installé avec Homebrew. Sur Linux, relancez le script d’installation curl -fsSL https://ollama.com/install.sh | sh qui détectera automatiquement qu’Ollama est déjà installé et effectuera la mise à jour.

Oui, tous les modèles disponibles dans la bibliothèque Ollama sont open source et gratuits. Ils sont distribués sous des licences permissives comme Apache 2.0, MIT ou Llama Community License. Vous pouvez les utiliser gratuitement, y compris pour un usage commercial, sans frais d’API ni limitations d’utilisation. Le seul coût réel est votre consommation électrique et l’espace disque occupé par les modèles.

Oui, Ollama supporte les architectures ARM64, ce qui inclut les Raspberry Pi 4 et 5. Cependant, les performances seront limitées par la RAM disponible (8 Go maximum sur le Raspberry Pi) et l’absence de GPU dédié. Privilégiez les modèles très légers comme TinyLlama 1.1B ou Llama 3.2 1B pour une expérience acceptable sur Raspberry Pi.